28 de jan. de 2026

Nando

CEO | FOUNDER

Recriar uma abertura icônica de anime como Dragon Ball é, ao mesmo tempo, um desafio técnico e uma aventura criativa. Não se trata apenas de copiar o original, mas de reinterpretar cenas, movimentos e atmosferas de maneira que a essência permaneça, enquanto novas camadas visuais são exploradas.

Na Human, esse projeto foi conduzido com a combinação de criatividade humana, inteligência artificial e rigor técnico, permitindo transformar algo complexo em uma nova animação coerente, dinâmica e visualmente impactante.

O objetivo por aqui sempre foi claro: mostrar que IA não serve para substituir o processo criativo de animar, mas para expandir. Desde o início, a equipe tinha consciência de que trabalhar com uma obra tão reconhecida exigia responsabilidade estética e respeito pelo material original. Ao longo do desenvolvimento, o projeto se destacou não apenas pelo resultado final, mas pelo aprendizado gerado no caminho. Cada quadro, cada personagem e cada cenário passou por ciclos intensos de testes, ajustes e recriações, revelando na prática como a IA pode ser aplicada em workflows de alta exigência, onde decisões técnicas, estéticas e conceituais caminham juntas.

Veja agora como a equipe da Human trabalhou, quais ferramentas utilizou e como lidou com os desafios ao longo do projeto.

Planejamento criativo e decisões iniciais na recriação da abertura de Dragon Ball com IA

Para muita gente, assistir Dragon Ball fazia parte da rotina, dos momentos em frente à TV e das primeiras experiências com narrativas épicas em animação. A nossa escolha também não foi aleatória. Além do fator nostalgia, trabalhar com uma base conhecida oferece uma vantagem estratégica clara: a estética visual já está definida, o ritmo da narrativa é familiar e a forma como os personagens se comportam faz parte do imaginário coletivo.

A abertura original funciona como um storyboard completo, com ritmo, enquadramentos e intenções bem definidos, o que permite deslocar o foco criativo da invenção da narrativa para a transformação estética e técnica.

Ao mesmo tempo, essa familiaridade aumenta o nível de exigência. Qualquer deslize visual, inconsistência de personagem ou escolha estética fora de tom se torna imediatamente perceptível. O nosso desafio não era apenas “fazer funcionar”, mas fazer com que o resultado fosse imediatamente reconhecível como Dragon Ball, mesmo em uma linguagem visual completamente diferente.

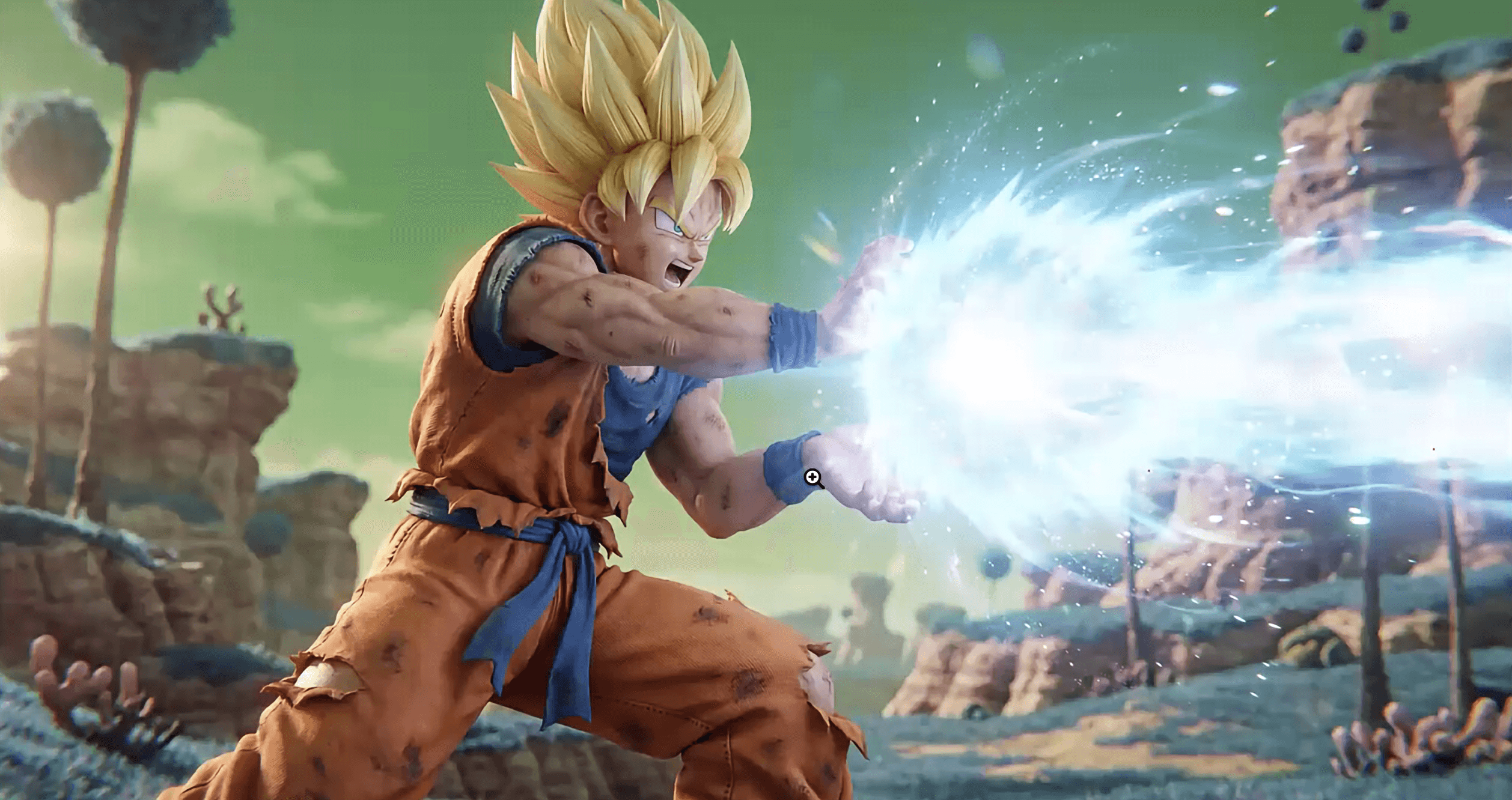

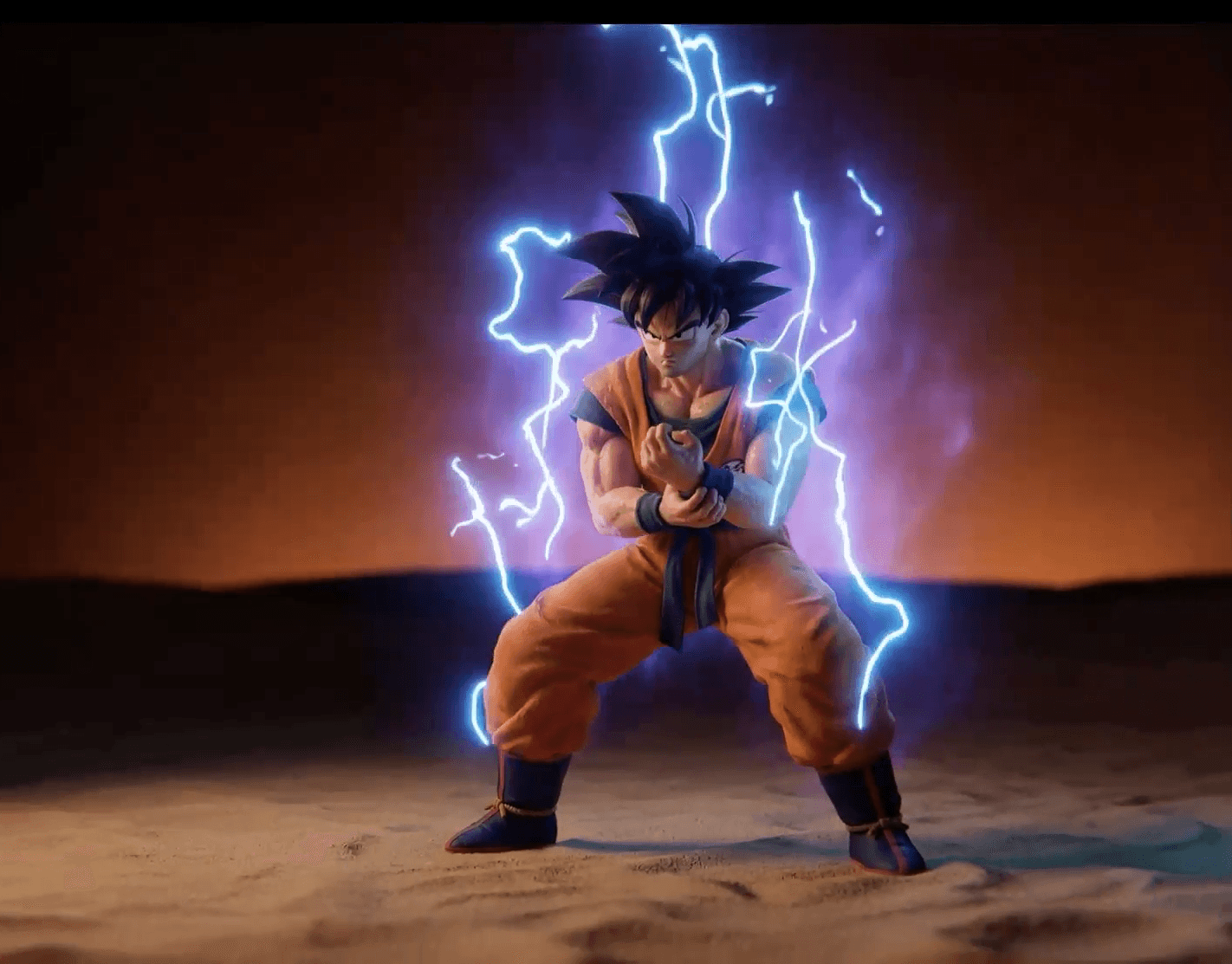

Definição de linguagem visual em projetos de vídeo com IA

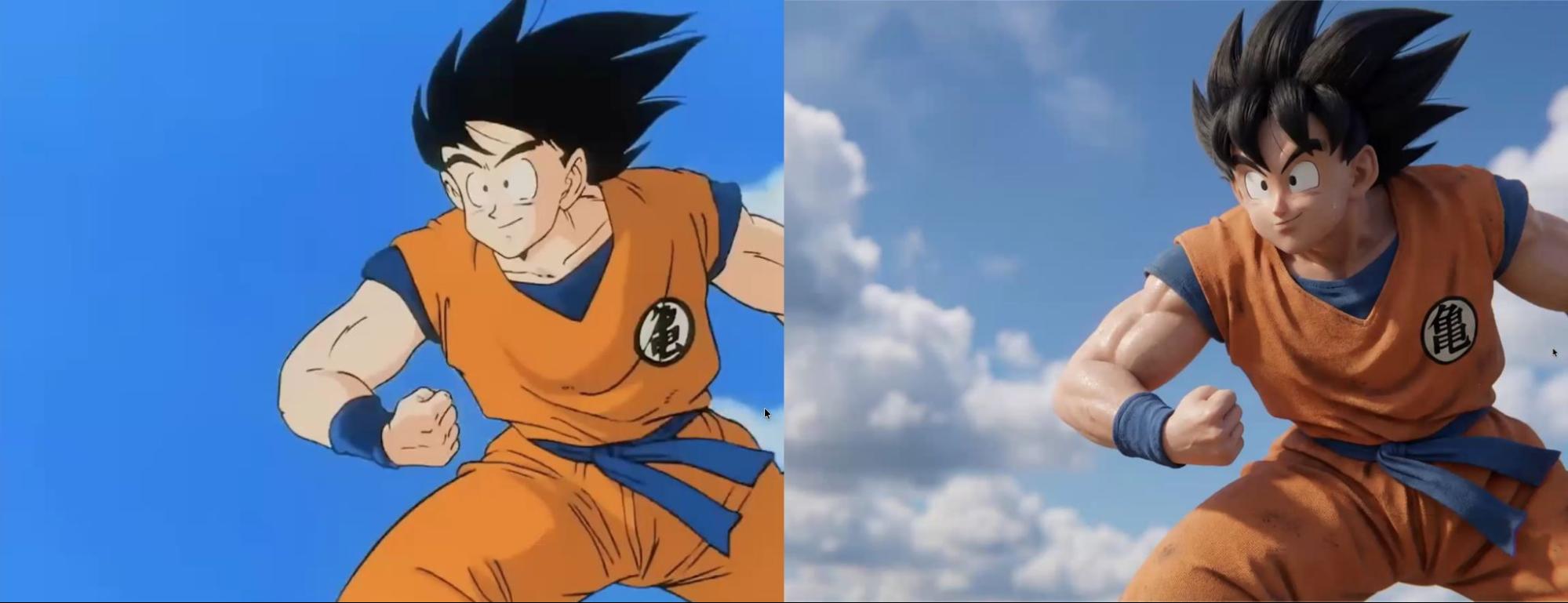

Antes de começar a trabalhar em qualquer ferramenta de IA, estabelecemos diretrizes técnicas bem precisas. A proposta era transformar um estilo de animação tradicional japonesa em algo com textura de pele realista, roupas com peso e caimento autênticos, iluminação profissional e uma linguagem visual mais próxima de produções contemporâneas em 3D. Essa adaptação de linguagem exigiu planejamento cuidadoso, decisões conscientes e a aceitação de que o processo seria, necessariamente, iterativo.

Essa primeira etapa, muitas vezes negligenciada por quem está começando, foi determinante para o resultado final. Em vez de gerar imagens aleatórias esperando que algo “funcionasse”, a equipe pensou como um time de direção de arte e fotografia, fazendo algumas perguntas-chave: qual seria a fonte de luz predominante? Qual a sensação de profundidade desejada? O contraste deveria ser mais suave ou mais marcado?

Todas essas decisões aconteceram antes de qualquer prompt ser escrito

Essa definição prévia é fundamental e evita um erro comum entre criadores iniciantes, que começam a gerar imagens sem saber exatamente o que querem. Quando é assim, o resultado costuma ser uma sequência de variações desconectadas, tempo desperdiçado e frustração. Quando a estética está bem definida logo de cara, cada prompt passa a funcionar como uma ferramenta de precisão, não como um tiro no escuro.

Nas imagens geradas, isso se traduziu em escolhas visuais consistentes, como a presença recorrente de uma luz lateral suave, capaz de criar profundidade sem dramatizar excessivamente as cenas, por exemplo. Esse controle não surgiu por acaso. Foi resultado de repertório visual, referências bem escolhidas e de uma leitura atenta de como a IA responde a determinados estímulos visuais.

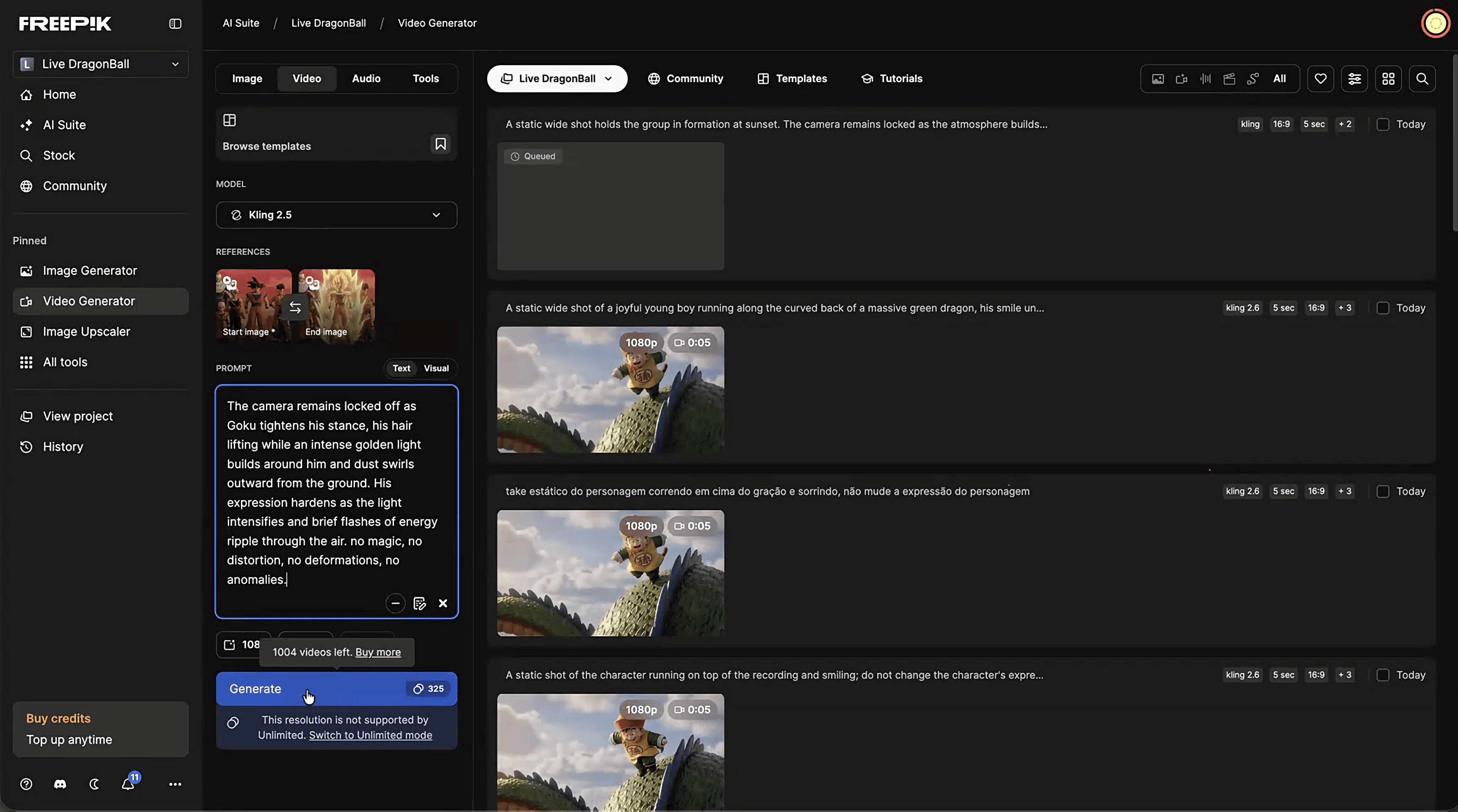

O workflow de animação com IA: Nano Banana Pro, Freepik, Higgsfield e Kling

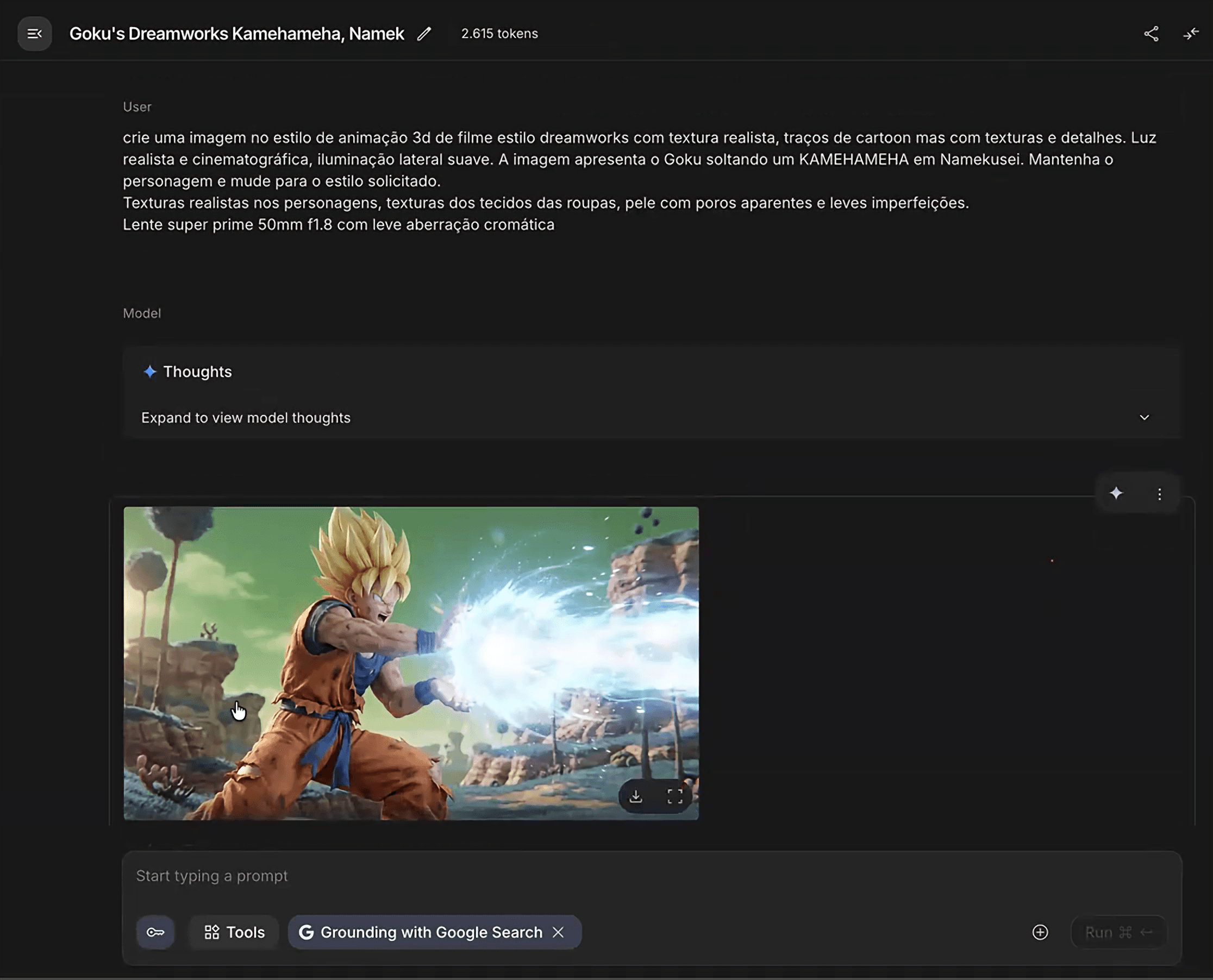

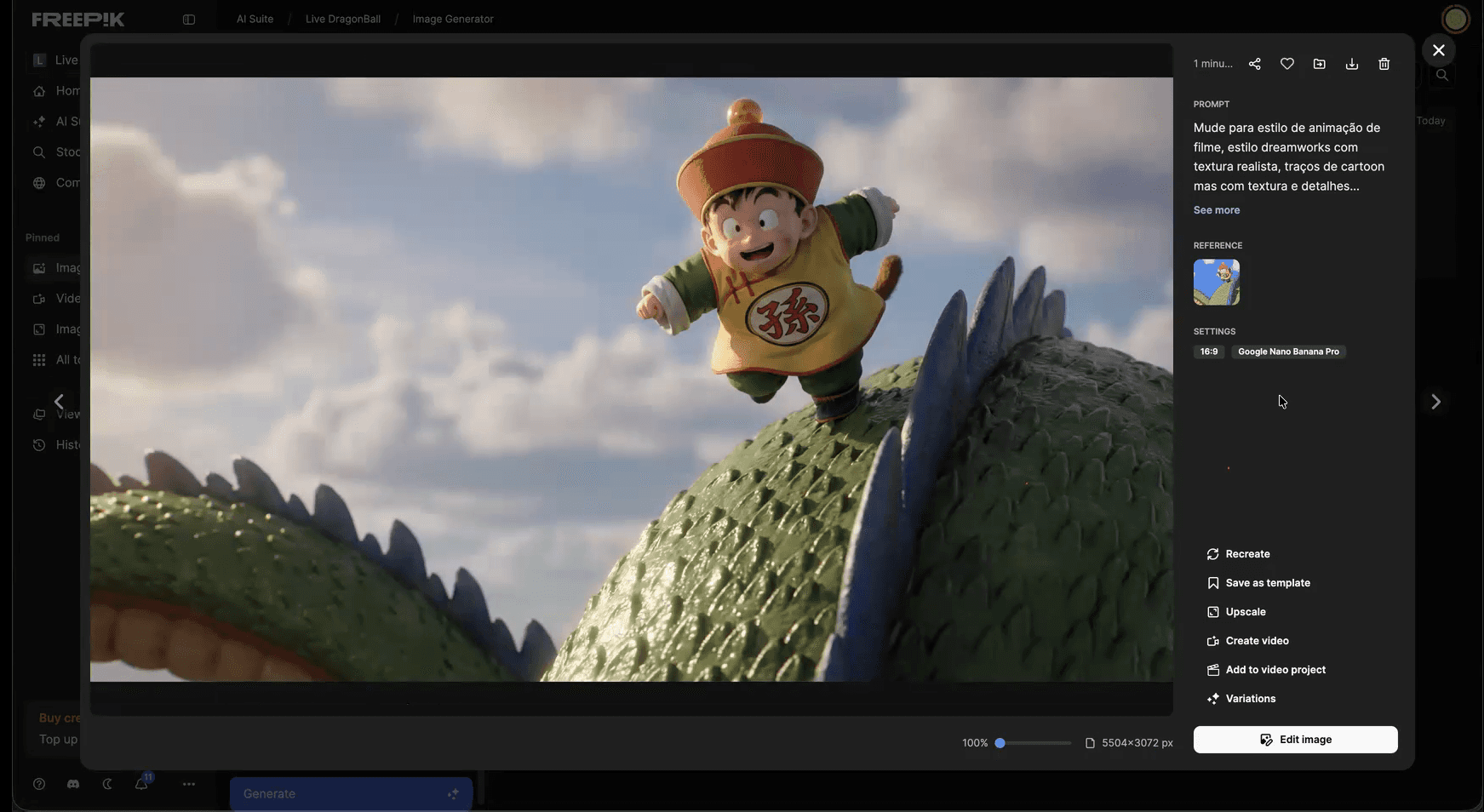

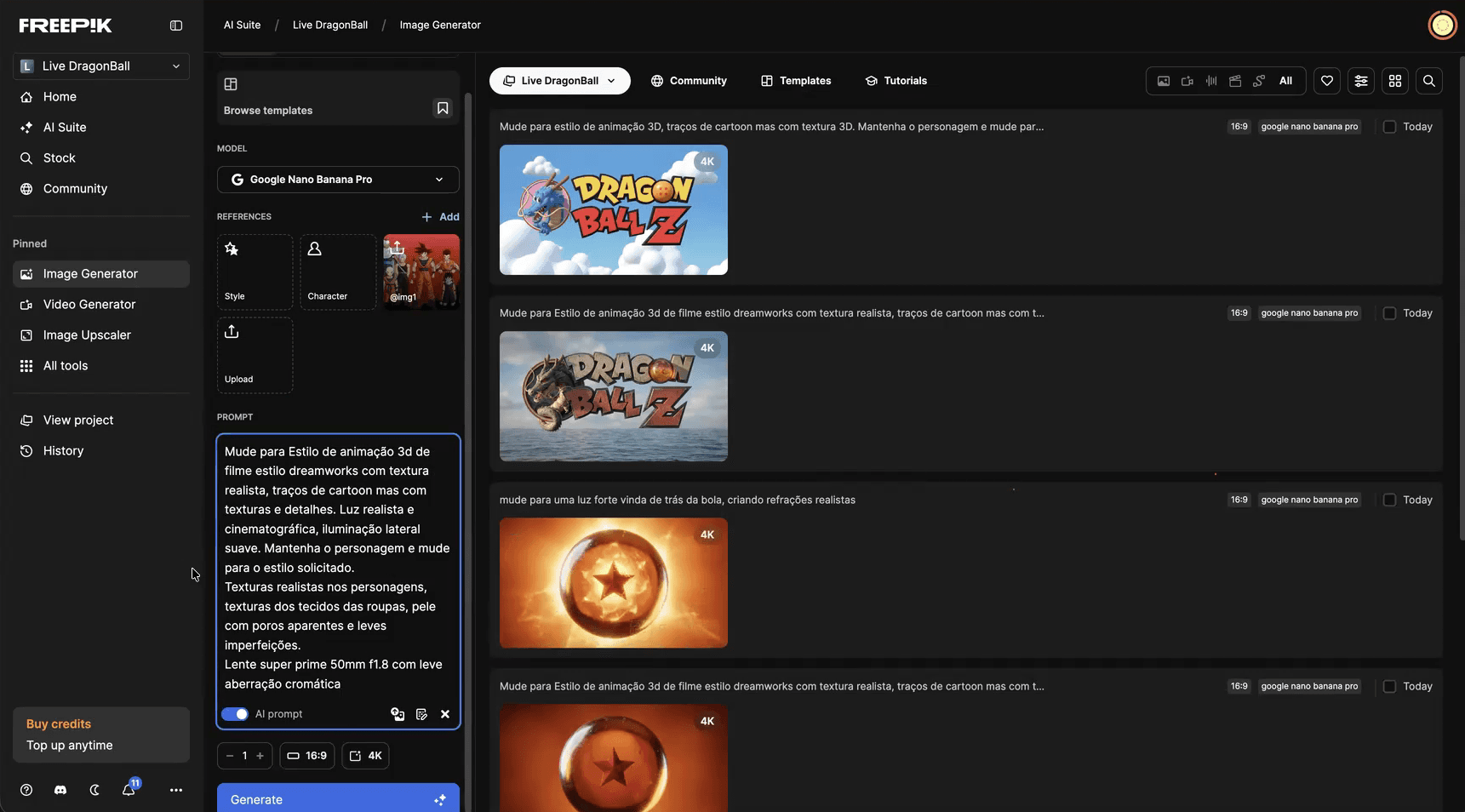

A escolha das ferramentas neste projeto reflete uma leitura clara de como cada plataforma contribui para o workflow criativo. A base da geração de imagens foi feita principalmente no Nano Banana Pro, escolhido pela sua capacidade de responder bem a referências específicas e manter consistência visual quando bem direcionado.

Ele se destaca por oferecer um bom controle de estilo, responder com precisão a prompts técnicos detalhados e aceitar imagens de referência com alto grau de fidelidade. Isso foi essencial para trabalhar sobre os frames já existentes da abertura original de Dragon Ball. A equipe utilizou o Nano Banana tanto através do AI Studio do Google, sua plataforma de origem, quanto através do Freepik, dependendo da velocidade de geração necessária e do tipo de recurso desejado.

Uso do Ground with Google Search em projetos de animação com IA

Uma funcionalidade que se mostrou particularmente poderosa foi o Ground with Google Search, disponível no AI Studio e também no Freepik. Com essa opção ativada, a ferramenta consegue buscar referências na internet para complementar o entendimento da imagem. Isso permitiu, por exemplo, usar termos coloquiais nos prompts, como "Goku lançando Kamehameha" ou mencionar nomes de personagens e locais do universo de Dragon Ball, sem precisar descrever visualmente cada elemento.

Na sequência, o fluxo foi complementado pelo Freepik, utilizado principalmente em momentos em que a equipe buscava variações rápidas de composição, ajustes finos ou alternativas de enquadramento. O Freepik oferece uma interface simplificada para editar imagens já geradas, permitindo mudanças específicas sem precisar regenerar toda a cena. Você pode arrastar uma imagem gerada de volta para a ferramenta e pedir alterações pontuais, como ajustar a iluminação ou modificar elementos específicos.

Já o Higgsfield entrou no fluxo em etapas mais avançadas, especialmente quando surgia a necessidade de ajustes de iluminação em materiais já gerados, graças à sua funcionalidade de relight e alteração de estilo em vídeos existentes.

Como o processo não se encerra na geração de imagens estáticas, aqui entra o Kling (tanto na versão 2.5 quanto na 2.6), ferramenta de geração de vídeo escolhida para animar as cenas. No entanto, usar o Kling de forma eficiente exige estratégia e compreensão das suas limitações. Gerar vídeos com movimento extremo ou ações muito complexas em uma única tentativa raramente funciona. A nossa solução foi dividir o movimento em partes menores, trabalhar com transições mais sutis e usar a consistência de personagem como aliada.

Leia também: Comparativo de IA de vídeo: Veo 3, Kling, Seedance, Freepik, Higgsfield e Sora

Dicas de prompts para controlar estilo e consistência em animações com IA

A construção dos prompts foi tratada como um processo técnico e criativo ao mesmo tempo. A equipe desenvolveu um prompt base robusto, que incluía referências de estilo 3D realista, especificações de câmera (como lente 50mm com abertura 1.8 para criar bokeh no fundo) e detalhes de iluminação, incluindo a aberração cromática característica de certas lentes.

Aqui está um ponto crucial do processo: entender o que não precisava estar no prompt. Como a imagem base da abertura original de Dragon Ball já era utilizada como referência visual direta, não havia necessidade de descrever a ação ou a composição da cena. O foco do prompt estava exclusivamente na transformação estética e técnica da imagem.

Essa decisão teve impacto direto na eficiência do workflow. Menos tokens desperdiçados, menos ruído interpretativo por parte da IA e maior consistência entre gerações.

Diferença entre prompts descritivos e direcionais na animação com IA

Um aprendizado importante veio da diferença entre descrever a imagem e direcionar o movimento. Para animação no Kling, prompts mais limpos e focados no que deveria acontecer funcionavam melhor do que descrições detalhadas da composição visual.

A razão: ferramentas de animação já interpretam a imagem fornecida. Descrever excessivamente pode criar conflito entre o que a IA vê na imagem e o que está sendo descrito no texto. Por isso, a equipe adotou prompts diretos como "plano estático, personagem correndo sobre dragão", deixando que a ferramenta leia os detalhes visuais da imagem de referência.

👉 Aprofunde: Introdução ao Briefing para IA: dicas práticas para criar prompts que funcionam

Consistência de expressões faciais em personagens gerados por IA

Um problema recorrente durante a animação foi a ferramenta para alterar a expressão facial dos personagens durante o movimento. Mesmo em cenas simples, onde o personagem deveria apenas manter uma pose enquanto corria, a IA tendia a modificar sutilmente o rosto frame a frame.

A solução foi adicionar explicitamente ao prompt: "não alterar a expressão do personagem". Esse tipo de instrução negativa ajudou a manter a consistência facial ao longo das animações, embora nem sempre com total sucesso. Em alguns casos, pequenas alterações de expressão ainda aconteciam, mas de forma menos comprometedora.

Ainda assim, o processo exigiu muitas gerações. Algumas cenas precisaram ser geradas repetidamente até atingir o resultado desejado. A ideia de que existe um caminho direto e simples é ilusória. Cada frame passou por testes, ajustes e, frequentemente, regenerações completas.

Do conceito aos frames finais: workflow prático de geração com IA

O processo começou com a identificação dos frames-chave da abertura original. Não se tratava de animar cada segundo sequencialmente, mas de mapear os momentos visuais mais marcantes e trabalhar cada um como uma unidade independente que, depois, seria integrada ao conjunto.

Para cada frame selecionado, a imagem original da abertura de Dragon Ball era carregada no Nano Banana junto com o prompt base. A partir daí, testes e variações eram realizados até encontrar o resultado desejado.

Start Frame e End Frame na geração de vídeo com IA

Uma funcionalidade que se mostrou essencial para controlar melhor os resultados foi o uso de start frame e end frame no Kling. Ao invés de fornecer apenas uma imagem inicial e deixar a ferramenta decidir como a animação deveria terminar, fornecer tanto o frame inicial quanto o final garantia maior controle sobre o movimento.

Importante: no momento do projeto, o Kling 2.6 dentro do Freepik apresentava uma limitação técnica que impedia o uso de end frame. Por isso, a equipe utilizou especificamente o Kling 2.5 para trabalhos que exigiam controle tanto do frame inicial quanto do final. O Kling 2.6 ficou reservado para animações que necessitavam apenas de start frame.

Essa técnica foi particularmente útil para manter a consistência de personagens. Quando você trabalha apenas com start frame, a ferramenta tem liberdade para interpretar o movimento final, o que pode levar a deformações ou mudanças indesejadas. Com end frame definido, a animação flui entre dois pontos conhecidos e aprovados.

No entanto, isso também exige planejamento. É preciso pensar como a cena funcionará do início ao fim. Se você simplesmente mudar o ângulo da câmera entre start e end frame sem considerar o movimento do personagem, a ferramenta criará uma animação onde apenas a câmera se move e o resto permanece estático, o que pode não ser o resultado desejado.

Erro comum em animações com IA: ausência de elementos-chave na referência

Um exemplo prático desse processo iterativo aconteceu em uma cena de close-up do Goku voando. Nos primeiros testes, a equipe simplesmente forneceu a imagem de referência da abertura original sem especificar a nuvem voadora no prompt. O resultado: Goku aparecia flutuando no ar sem suporte visível.

A solução foi voltar ao prompt e adicionar explicitamente: "Goku sobre nuvem voadora". Com essa especificação, o Nano Banana usou a pose da referência, mas incluiu corretamente a nuvem, respeitando inclusive a perspectiva e criando uma continuidade visual com o plano anterior, como se fosse uma abertura natural da câmera.

Esse tipo de ajuste demonstra que, mesmo com imagens de referência, algumas informações precisam ser explicitadas no texto do prompt para garantir que elementos importantes não sejam ignorados pela ferramenta.

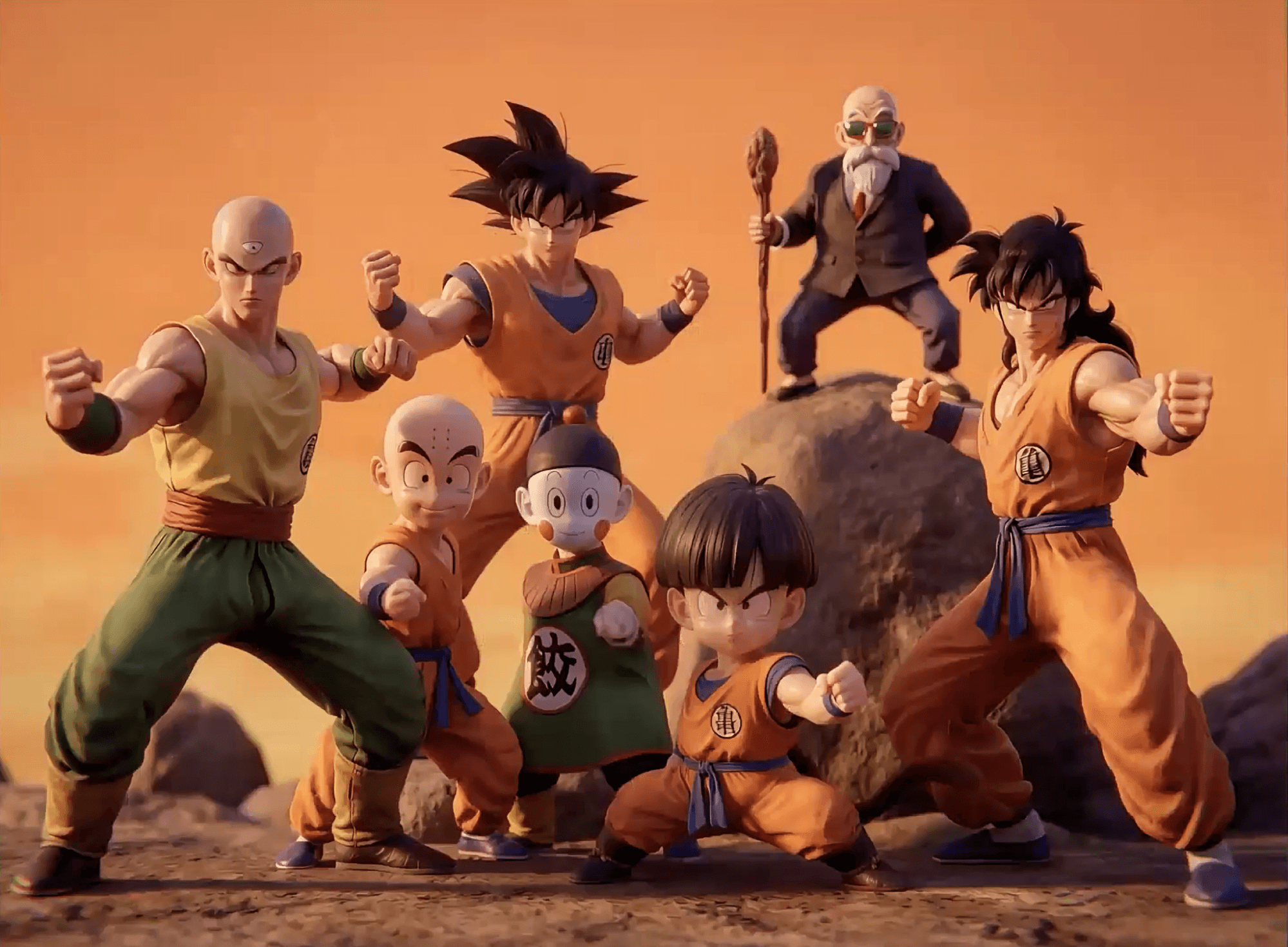

Consistência de personagem em animação com IA: como manter o Goku reconhecível

Um dos maiores desafios ao trabalhar com geração de imagens por inteligência artificial é manter a consistência de um personagem. Quando você gera dezenas de imagens diferentes do Goku, cada uma pode sair com pequenas variações no rosto, na musculatura ou nas proporções.

A abordagem da Human foi criar uma versão do Goku considerada ideal e utilizá-la como referência constante para todas as gerações subsequentes. No Nano Banana, isso significa incluir a imagem de referência junto com cada prompt, garantindo que a ferramenta mantenha as características faciais e corporais consistentes.

O Ground with Google Search também desempenhou papel importante nesse processo. Com essa funcionalidade ativa, a ferramenta busca referências de "Goku" na internet e combina com a imagem fornecida, aumentando a precisão na recriação das características do personagem. Isso foi especialmente útil quando não havia frame de referência direto da abertura original para determinada cena.

Soluções híbridas: uso do Photoshop em vídeos com IA

Mesmo com todas as precauções, algumas gerações apresentavam inconsistências que precisavam ser corrigidas. Aqui entra o Photoshop como ferramenta complementar ao workflow de IA.

O Photoshop oferece ferramentas de seleção de assunto e máscaras que facilitam correções pontuais. Mais do que isso, a versão atual já tem integração nativa com Nano Banana, permitindo que você selecione uma área específica da imagem e use a IA para editar apenas aquela região, mantendo o resto intacto.

Essa abordagem híbrida, combinando geração por IA com edição tradicional, foi essencial para manter o padrão de qualidade elevado ao longo de todo o vídeo. Em alguns casos, quando a discrepância era muito grande, a decisão era simplesmente regenerar a cena completa até obter um resultado satisfatório.

Leia também: Workflow híbrido: combinando IA com ferramentas tradicionais

Processo iterativo na animação com IA: testes e ajustes

Durante o desenvolvimento do projeto, o processo iterativo foi intenso. Muitas cenas precisaram ser geradas repetidamente. A equipe enfrentou diversos desafios técnicos que exigiram experimentação e ajustes constantes.

O desafio das rotações de câmera e das “alucinações”

Um problema recorrente apareceu em cenas com movimento de câmera, especialmente rotações orbitais. Quando a câmera gira ao redor de um personagem, a ferramenta de vídeo tende a "alucinar" bastante, alterando a lógica do plano, mudando detalhes do personagem ou criando inconsistências visuais.

Por exemplo, em cenas onde deveria haver um movimento orbital suave, a ferramenta às vezes mudava elementos do fundo do personagem ou criava artefatos visuais estranhos. A solução encontrada foi especificar claramente o tipo de movimento desejado: "órbita lenta à esquerda ao redor da cena", mantendo os prompts simples e diretos.

Quando a IA não entende o prompt em animações

Houve situações em que, independentemente dos ajustes no prompt, a ferramenta simplesmente não conseguia entregar o resultado desejado. Em uma cena específica da nuvem voadora, a equipe precisou gerar múltiplas vezes para conseguir que a animação criasse corretamente o rastro da nuvem durante o movimento.

Um aprendizado importante aqui: às vezes, continuar gerando 30 vezes a mesma coisa não resolve. É preciso reconhecer quando a abordagem não está funcionando e mudar a estratégia. Talvez o problema seja o prompt, talvez seja a complexidade da cena, talvez seja necessário dividir o movimento em partes menores ou até mesmo criar elementos separadamente e combinar na edição.

Problemas de consistência em planos abertos gerados por IA

Outro padrão identificado foi que ferramentas de geração de vídeo tendem a ter muito mais hallucination quando o plano é muito aberto e os personagens aparecem pequenos no frame. Faces e detalhes finos se perdem com mais facilidade nessas situações.

A solução para isso foi usar end frame de forma estratégica justamente para garantir que, mesmo em planos distantes, as características dos personagens se mantivessem consistentes do início ao fim da animação.

Erros de iluminação em vídeos gerados por IA

Durante os testes de uma cena específica, a equipe percebeu que a ferramenta constantemente interpretava que havia uma fonte de luz externa à composição. Sempre que faziam zoom out, a IA criava automaticamente uma fonte de luz lateral ou algum elemento luminoso que não fazia parte do universo visual desejado.

Esse tipo de interpretação indesejada exigiu várias tentativas, ajustando o prompt para ser mais explícito sobre a iluminação desejada e, em alguns casos, usando edição posterior para remover ou ajustar esses elementos adicionados pela IA.

Edição e montagem final: estruturando a animação com IA

Depois de gerar todas as cenas individuais, o trabalho ainda está longe de terminar. É nesse momento de edição final que tudo precisa funcionar como um conjunto coeso. Ferramentas profissionais de edição de vídeo são utilizadas para montar as cenas, ajustar o timing, adicionar transições e garantir que o ritmo da abertura flua naturalmente.

Topaz Video Upscaler e a técnica de slow motion em filmes com IA

Uma estratégia importante revelada no processo foi o uso do Topaz Video Upscaler não apenas para aumentar a qualidade das imagens, mas como ferramenta criativa. A equipe usou o Topaz para transformar animações em slow motion, expandindo o tempo de cenas específicas sem precisar gerar vídeos mais longos diretamente na ferramenta de IA.

Na prática: uma animação gerada em 5 segundos pode ser transformada em uma take muito maior através do Topaz, criando momentos de ênfase dramática e facilitando pontos de corte na edição. Isso economiza créditos nas ferramentas de IA e oferece maior controle criativo sobre o timing final.

Efeitos de pós-produção também são adicionados: correção de cor para unificar a estética de todas as cenas geradas em momentos diferentes do processo, ajustes de contraste e saturação e pequenos efeitos visuais que complementam a animação gerada por IA.

A trilha sonora original de Dragon Ball foi mantida, o que ajudou a criar a conexão emocional com o material original. Mas o timing precisava ser perfeito. Cada corte, cada transição precisava estar sincronizada com a música para que a abertura funcionasse como um todo coeso.

O resultado:

Aprendizados estratégicos de animação com IA para inspirar outros criadores

O processo de recriação da abertura de Dragon Ball oferece lições importantes para qualquer criador trabalhando com inteligência artificial:

Clareza é poder: antes de gerar qualquer imagem, tenha absoluta clareza sobre o que você quer. Defina a estética, a iluminação, o estilo. Quanto mais específico você for, mais eficiente será seu processo. Mas lembre-se: especificidade não significa descrever tudo. Significa saber exatamente quais elementos técnicos precisam estar no prompt e quais a ferramenta já consegue inferir da imagem de referência.

Divida para conquistar: não tente fazer tudo em uma única geração. Divida seu projeto em partes menores, trabalhe cada uma com atenção e depois monte o resultado final. Animações mais curtas são mais fáceis de controlar e você sempre pode estender ou ajustar o timing na edição.

Teste sem medo, mas reconheça limites: seus primeiros resultados provavelmente não serão perfeitos. Teste, ajuste, regenere. Cada iteração ensina algo novo sobre como a ferramenta funciona. Mas também aprenda a reconhecer quando um workflow não está funcionando. Se você tentou muitas vezes e nenhuma ficou satisfatória, o problema provavelmente não é sorte, é abordagem. Mude a estratégia.

Combine ferramentas estrategicamente: não se limite a uma única plataforma. Nano Banana para geração base, Freepik para ajustes rápidos, Kling para animação, Photoshop para correções pontuais, Topaz para slow motion e upscaling, ferramentas de edição para unificar tudo. Cada uma tem seus pontos fortes e entender quando usar cada uma faz toda a diferença.

Crie repertório: entender iluminação, composição, movimento de câmera não é apenas útil, é essencial. Inteligência artificial pode gerar imagens, mas você precisa saber direcionar essas imagens com conhecimento técnico e visão artística. Estude fotografia, assista análises de cinematografia, desconstrua aberturas de animes que você admira. Esse conhecimento se traduz diretamente em prompts melhores e decisões mais acertadas.

Filmes com IA não nascem do algoritmo, nascem de decisões criativas

A inteligência artificial já mudou como a animação é produzida, isso é fato. Plataformas como Nano Banana, Kling, Higgsfield, Freepik e MidJourney colocaram nas mãos de criadores a capacidade de gerar movimento, estilo e volume em uma velocidade inédita. O vídeo generativo deixou de ser experimento e passou a funcionar como infraestrutura real do audiovisual, usada por marcas, estúdios e criadores independentes.

Mas aqui vai o ponto que realmente importa: ferramenta nenhuma sustenta uma história sozinha. Apertar botões pode até ser fácil. O difícil e valioso é saber como estruturar uma ideia, quando intervir, por que escolher um caminho e como transformar erros em linguagem. É aí que entra a direção criativa. Ritmo, intenção, pausa, peso e energia continuam sendo decisões humanas e é isso que separa um vídeo genérico de uma peça que cria conexão de verdade.

A recriação da abertura de Dragon Ball pela Human deixou isso claro. Cada ajuste de tempo, cada escolha estética e cada iteração foram guiados por visão, repertório e critério e não pelo acaso do algoritmo. Criar impacto exige consciência criativa.

É exatamente desse olhar que surge o AI VideoLab, o primeiro workshop da Human em 2026. Em 12 horas de prática intensa, nos dias 28 de fevereiro e 1º de março, você acompanha processos reais de criação, explorando animação 2D, 3D realista, stop motion e anime, com mais testes, erros e refinamentos acontecendo ao vivo.

Aqui, a IA não é o fim, ela é o meio. Você aprende a transformar tecnologia em estratégia, a acelerar ideias sem perder intenção e, principalmente, a dirigir a máquina como extensão do seu talento criativo.

👉 Se você quer sair do modo operador e assumir o papel de diretor no novo audiovisual, o AI VideoLab é o seu próximo passo. Faça sua inscrição.

A criação de verdade não acontece no render final. Ela acontece no processo.

Para mergulhar ainda mais nos processos de vídeo com IA, confira também nosso artigo sobre os fluxos de criação e modelos no Midjourney e Freepik.