27 de jan. de 2026

Human Picks

Staff

Criar animações nunca foi apenas uma questão técnica, mas o resultado de uma intenção clara que orienta cada escolha ao longo do processo. É esse olhar que transforma rascunhos em narrativa.

Mesmo com a entrada de ferramentas de inteligência artificial no fluxo criativo, esse princípio continua igual, mudando apenas a forma como as ideias ganham corpo. Testes acontecem mais rápido, referências se tornam mais acessíveis e caminhos visuais passam a ser explorados com menos fricção, abrindo espaço para experimentação e produção autoral em diferentes escalas.

Ao longo da história, a animação sempre acompanhou avanços tecnológicos sem romper com sua base criativa. Do stop-motion aos longas em CGI, cada evolução técnica reorganizou métodos, preservando a sensibilidade e a direção criativa como eixo do processo. A inteligência artificial se insere nesse percurso como mais uma camada de transformação, conectada a uma busca contínua por ampliação das possibilidades expressivas.

Hoje, Midjourney e Freepik já ocupam um papel de destaque nessa reorganização do processo de animação. Eles não animam por conta própria, mas ajudam a encurtar a distância entre a ideia inicial e o movimento final.

Compreender como funcionam, quais recursos oferecem e onde estão seus limites se tornou fundamental para quem busca produzir animação de forma consistente. O ponto central da discussão, portanto, não está na tecnologia em si, mas na maneira como essas ferramentas passam a integrar o fluxo criativo real, resolvendo problemas práticos e influenciando decisões estéticas ao longo do processo.

Por que falar de animação com IA é importante agora

Contexto histórico e mudanças no processo criativo

A inteligência artificial não surgiu de repente no campo criativo, mas por muito tempo esteve distante dos processos artísticos do dia a dia. Antes dela, a animação digital já vinha se desenvolvendo por outros caminhos. Dos experimentos iniciais em computação gráfica nos anos 1970 ao lançamento de Toy Story, em 1995, o primeiro longa totalmente em CGI, cada avanço ajudou a abrir novas linguagens e formas de produzir animação.

Nos últimos anos, o que fica mais claro não é o surgimento da IA em si, mas a forma como ela passa a se integrar ao processo. A partir da década de 2020, ferramentas de IA voltadas à criação visual passaram a lidar melhor com imagem, movimento e estilo visual, entregando resultados mais consistentes no fluxo de trabalho. Aos poucos, a IA foi deixando de ser algo distante e começou a ocupar um lugar mais prático na hora de animar.

Esse movimento não apaga técnicas tradicionais nem muda radicalmente a estrutura da indústria. Grandes produções continuam existindo e, em muitos casos, também passam a integrar a inteligência artificial aos seus processos. O que muda é o leque de possibilidades que se abre com conceitos visuais ganhando forma com mais rapidez e diferentes formas de criação passando a conviver dentro do mesmo ecossistema. Falar de animação com IA agora significa observar essa reorganização enquanto ela acontece.

O amadurecimento da IA no processo de animação

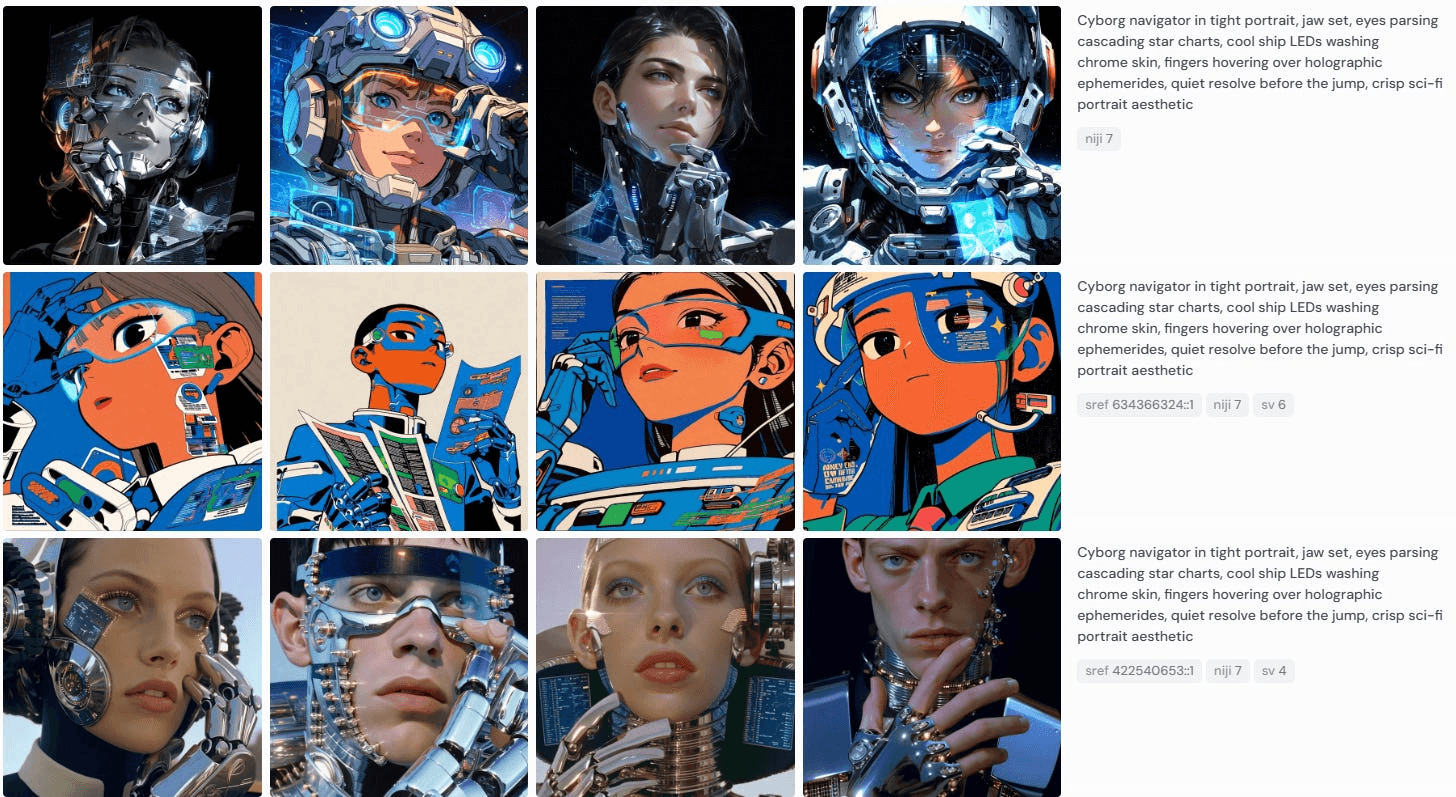

Plataformas como Midjourney e Freepik ajudam a entender esse momento de amadurecimento da IA na animação. O Midjourney, por exemplo, avança além da geração de imagens estáticas ao longo de 2025. Com a chegada da Versão 7, em abril, e do modelo de vídeo V1, lançado em junho, a ferramenta passa a se aproximar de um ambiente voltado também à animação, ampliando seu papel dentro do processo criativo e começando a dialogar com a construção de movimento, não apenas com a estética inicial.

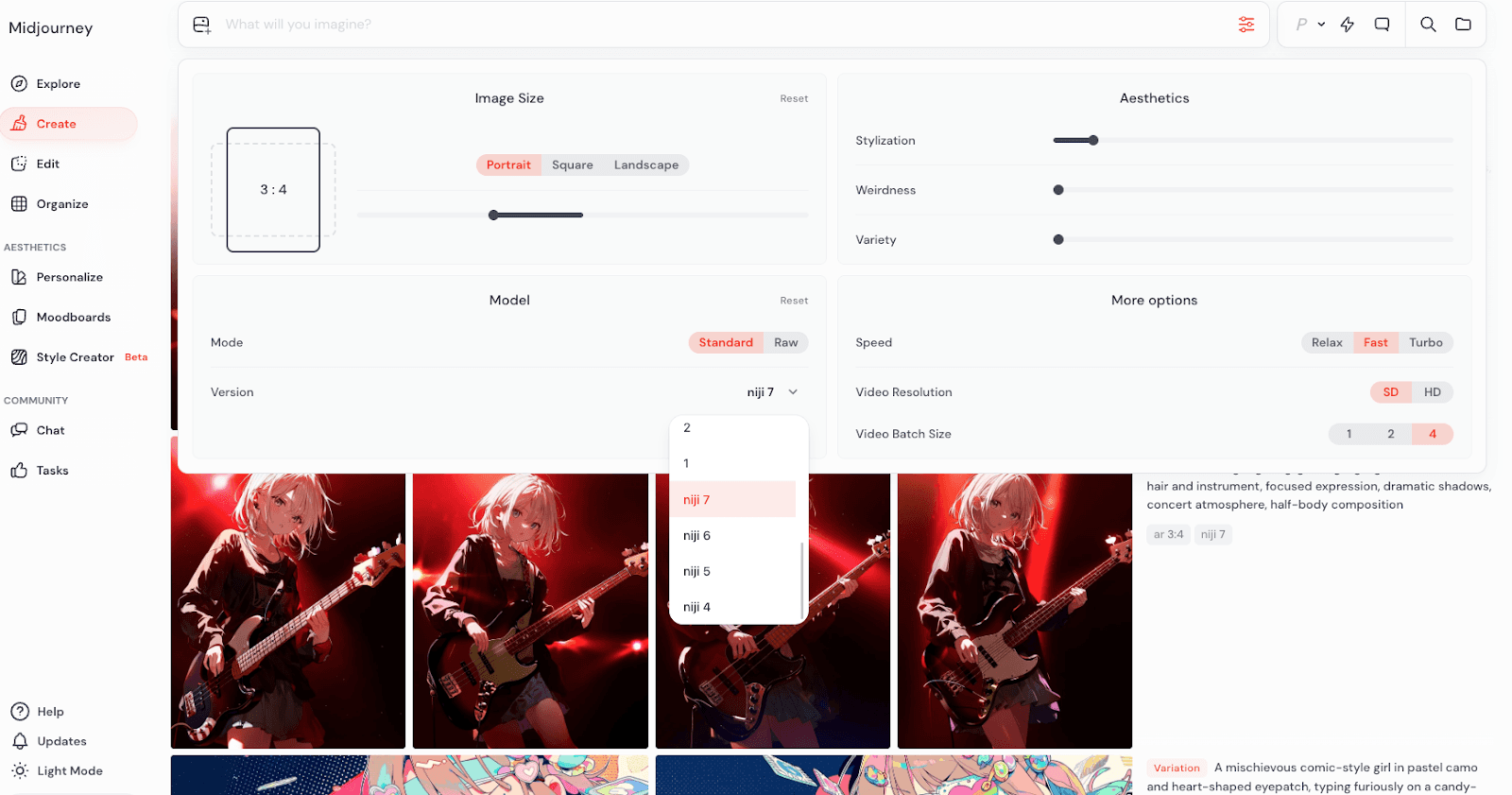

Esse movimento se torna ainda mais explícito com o lançamento do Niji V7, um modelo especializado em estética de anime e animação. Diferente do Midjourney padrão, o Niji já nasce orientado para personagens, expressividade e continuidade visual, aproximando a ferramenta de um uso mais direto na construção de cenas animadas, não apenas de frames isolados. É um sinal claro de que a plataforma passa a olhar para animação não como derivação, mas como território próprio dentro do ecossistema de IA criativa.

O Freepik segue um caminho diferente, mas complementar. A plataforma aposta na integração de múltiplos motores de IA em um mesmo ambiente. Em vez de oferecer um único modelo, o Freepik funciona como uma suíte unificada, na qual o animador escolhe a tecnologia mais adequada para cada etapa do processo. Isso reduz a fragmentação do fluxo e permite que a ferramenta se adapte às decisões criativas, não o contrário.

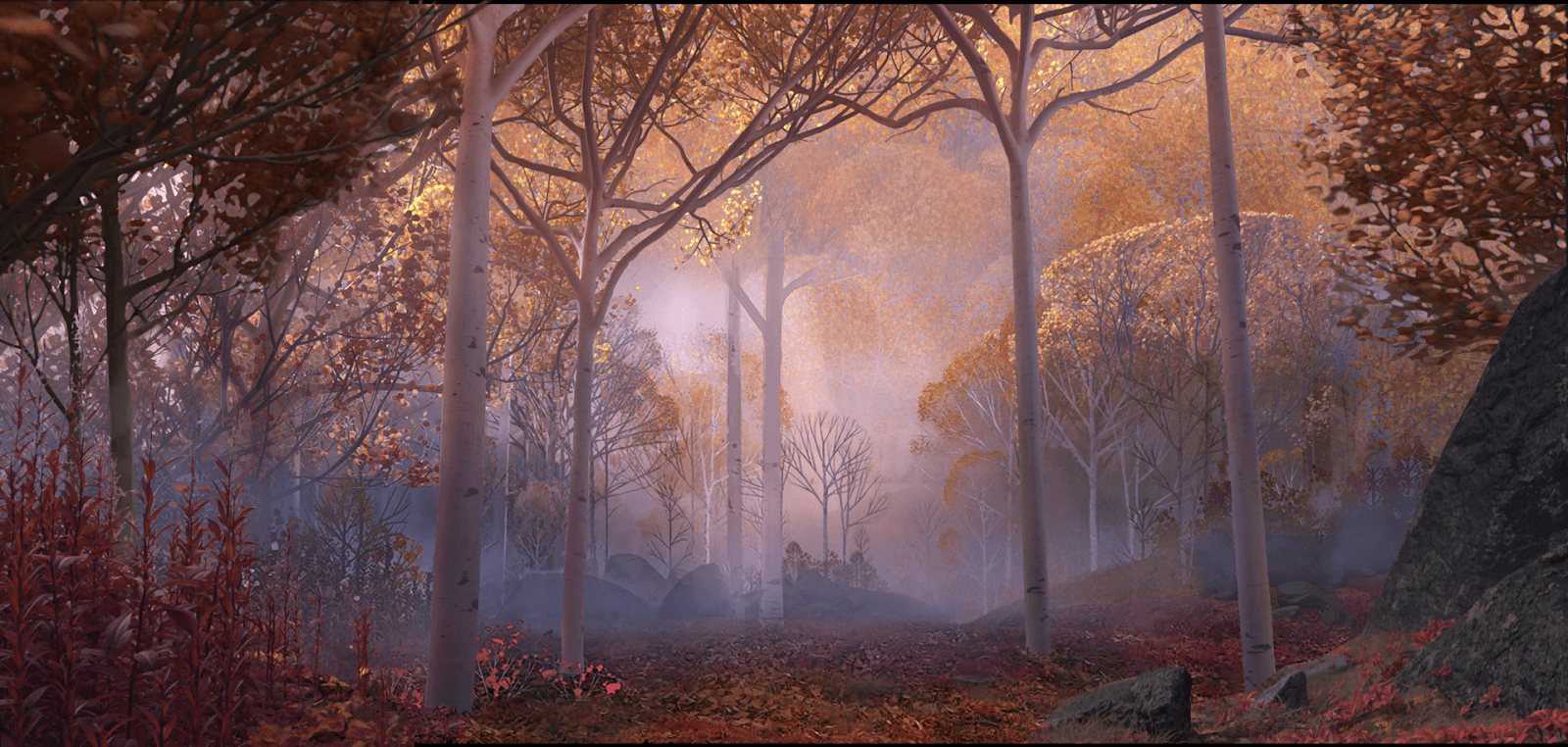

Essa transição fica mais clara quando observada na prática. Em 2019, simulações físicas complexas, como as usadas em Frozen II, dependiam de algoritmos proprietários da Disney e de equipes altamente especializadas para atingir o nível de realismo desejado. No filme, vento, água, neve e fogo não eram apenas efeitos visuais, mas personagens com intenção narrativa, o que exigiu o desenvolvimento de sistemas específicos para traduzir fenômenos naturais em atuação animada.

Para dar vida a Gale, o espírito do vento, a Disney criou o Swoop, uma ferramenta integrada ao Maya que permitia aos animadores desenhar o movimento do ar em ambientes de realidade virtual. Gestos humanos definiam trajetória, ritmo e intensidade, enquanto o algoritmo convertia essas ações em partículas e interações visuais coerentes em tempo real.

A renderização ficou a cargo do Hyperion, renderizador proprietário que incorporou aprendizado de máquina para acelerar o denoising e o feedback visual. Em cenas como “Show Yourself”, com milhares de reflexos no gelo, diretores de iluminação puderam tomar decisões criativas sem esperar horas por cada teste de render.

Já a física de neve e água foi resolvida por motores como Matterhorn e Splash, capazes de simular materiais com peso, elasticidade e fluidez controlados. Isso permitiu, por exemplo, que o Nokk, o cavalo de água, mantivesse volume e presença dramática mesmo sendo formado por líquido.

Sistemas procedurais como Bonsai e Flourish completaram o processo, gerando vegetação em larga escala e movimentos sutis de folhas e galhos, sempre com controle artístico, evitando simulações pesadas e imprevisíveis.

Em 2026, recursos semelhantes começam a aparecer em plataformas acessíveis. No Freepik, por exemplo, criadores já conseguem gerar movimentos fluidos a partir de prompts visuais simples, desenhando setas diretamente sobre a imagem para indicar trajetórias e dinâmicas de movimento.

O que antes ficava restrito a processos internos e fechados passa a circular em formatos mais abertos e experimentais.

Midjourney e a consistência visual na animação com IA

Como a ferramenta constrói estética e movimento

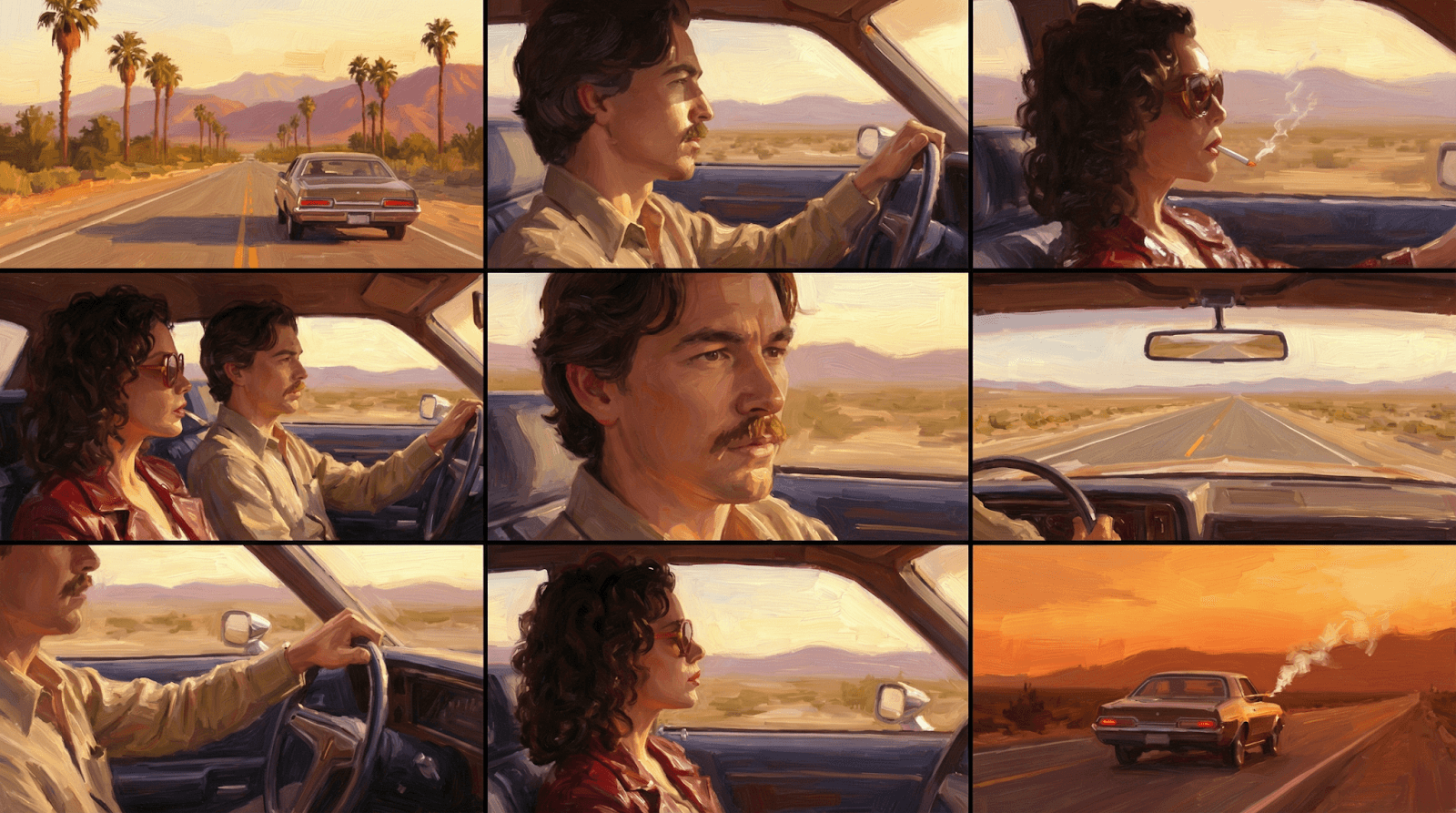

O Midjourney trabalha com modelos capazes de interpretar descrições em linguagem natural para gerar imagens com alto nível de detalhe. No contexto da animação, o principal diferencial está na capacidade de sustentar consistência visual ao longo de uma sequência. Personagens criados em uma cena podem reaparecer em ângulos diferentes, com variações de iluminação e enquadramento, sem perder traços faciais, vestuário ou expressões que definem sua identidade.

Com os modelos mais recentes, incluindo o Niji 7, imagens estáticas passam a ser transformadas em clipes de até 5 segundos, que podem ser estendidos para cerca de 21 segundos, com controle sobre a intensidade do movimento. É possível optar por animações mais sutis, adequadas a cenas contemplativas, ou por dinâmicas mais intensas, pensadas para sequências de ação e transições narrativas.

A fase de experimentação também se torna mais ágil. Iterações rápidas e com menor custo permitem explorar variações visuais logo no início do projeto, quando storyboards, animatics e testes visuais ainda estão sendo construídos. Esse processo facilita decisões criativas fundamentais antes de avançar para etapas de produção mais elaboradas.

IA para animação: recursos práticos para animadores no Midjourney

O Character Reference (--cref) mantém a identidade visual de personagens ao longo de múltiplas gerações. Com peso ajustável entre 0 e 100 (--cw), o recurso permite controlar quanto da referência será preservado, equilibrando fidelidade ao original com liberdade para exploração criativa. Quando você precisa que um personagem apareça em diferentes ângulos, iluminações ou contextos, mas sem perder traços essenciais como rosto, roupa ou expressão, esse parâmetro resolve o problema de forma direta.

A evolução desse sistema veio com o Omni Reference (--oref), introduzido na Versão 7 (V7). Ele garante precisão ainda maior na estabilização de objetos e personagens complexos, atacando diretamente o que sempre foi o maior obstáculo da animação com IA: manter consistência visual ao longo de muitas cenas. Se antes a IA tendia a gerar variações indesejadas entre um quadro e outro, agora o Midjourney promete diminuir a margem de erro consideravelmente.

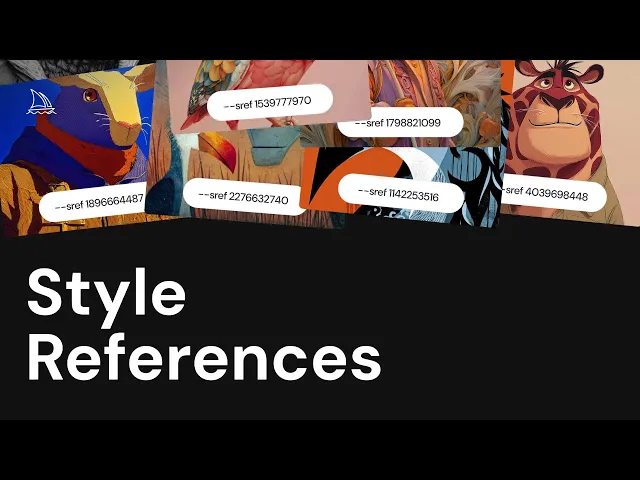

Já o Style Reference (--sref) bloqueia o estilo artístico baseado em uma URL de referência. Quando você define uma imagem como modelo estético, a ferramenta replica aquele visual em todas as gerações seguintes, garantindo uniformidade e coerência estética.

Na V7, a renderização de texto alcança níveis mais altos de precisão na geração de tipografia. Isso tende a reduzir etapas de pós-produção em elementos como cartazes, interfaces e letreiros animados, embora o refinamento final ainda dependa do contexto e do nível de exigência de cada projeto. Textos complexos ou com requisitos muito específicos ainda podem exigir ajustes, mas a base gerada já economiza tempo considerável.

Já o Draft Mode (--draft) foi pensado para os estágios iniciais do processo criativo, quando a liberdade de experimentação importa mais do que o acabamento final em si. Esse modo permite explorar ideias com mais liberdade e menos fricção. A geração acelerada favorece testes rápidos de narrativa visual, composição e movimento, ajudando a tomar decisões estruturais ainda na fase de esboço.

👉 Aprofunde: Tutorial e dicas de Midjourney: guia completo do iniciante ao avançado

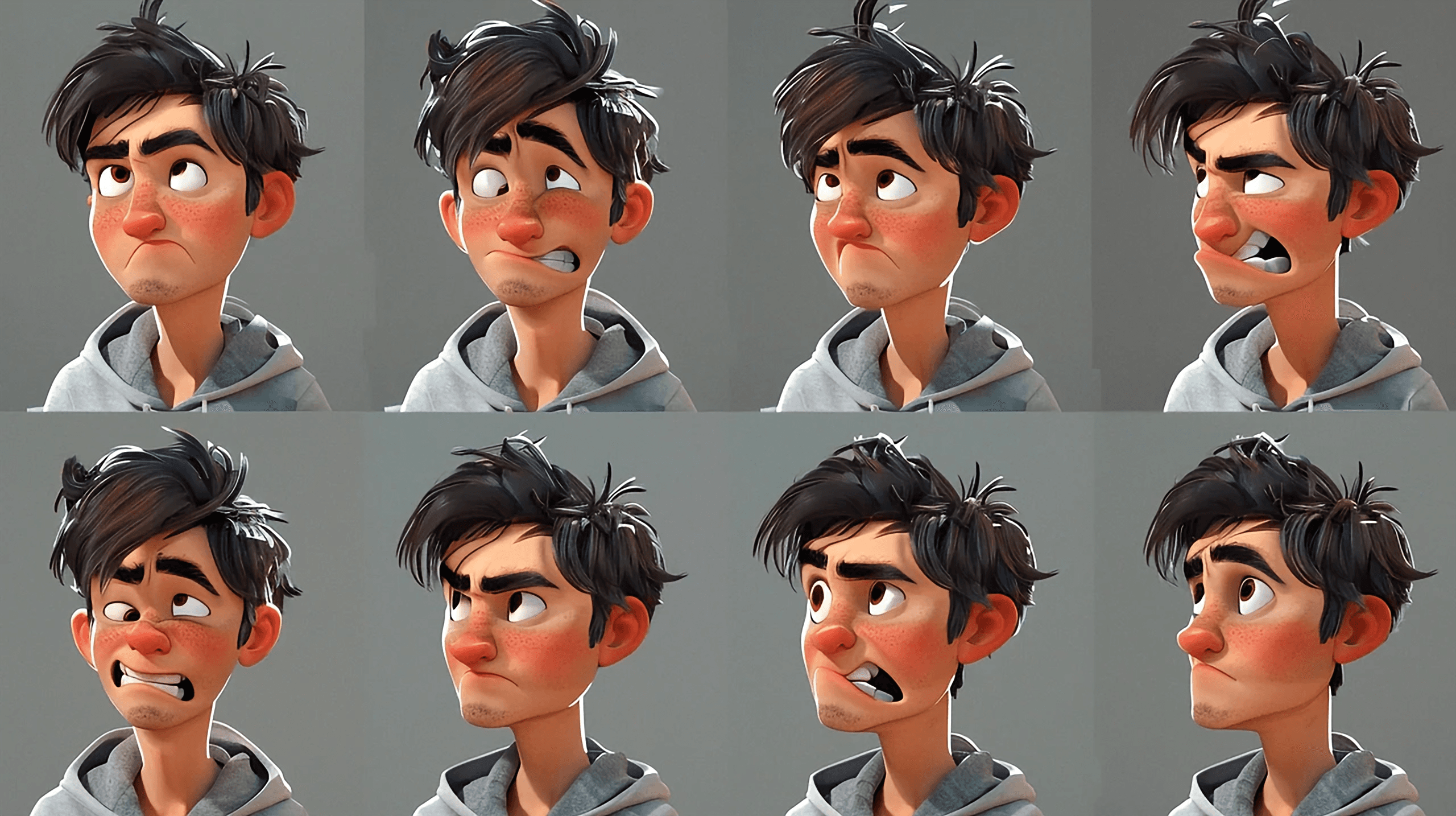

Niji 7: o modelo inspirado no anime, além da animação tradicional

Para quem curte trabalhar com estética japonesa, o Niji 7, resultado da colaboração entre Midjourney e Spellbrush, já é referência. Lançado em janeiro de 2026, o modelo oferece alto nível de coerência em detalhes como olhos, reflexos, contornos e leitura espacial, permitindo a criação de personagens expressivos, mas também composições gráficas mais limpas e controladas.

Embora tenha o anime como base visual, o Niji 7 vai além desse estilo. Sua fidelidade a prompts literais, o domínio sobre linhas bem definidas e o uso consciente de áreas vazias ao redor dos elementos tornam o modelo eficiente para ilustração editorial, design gráfico e até criação de logos minimalistas. Estilos podem variar do visual vibrante de séries animadas a abordagens mais autorais, próximas de livros ilustrados, com o uso de palavras-chave e diferentes enquadramentos de câmera.

Vale destacar que o Niji 7 é um modelo “opinativo”, mantendo uma assinatura estética japonesa mesmo fora do contexto de anime. Para quem busca resultados mais neutros, parâmetros como --style raw ajudam a reduzir essa estilização automática, ampliando o controle artístico sem perder precisão.

Freepik como hub de ferramentas de animação com IA

Uma suíte unificada para diferentes etapas da animação

Enquanto o Midjourney aprofunda a construção estética, o Freepik direciona seu foco para a organização do processo. A plataforma não se limita a modelos próprios, reunindo diferentes tecnologias de terceiros em uma única interface. Esse modelo de integração permite que o animador escolha, por exemplo, o Google Veo 3 para cenas animadas com composição visual mais estruturada, o Kling para movimentos de personagens mais estáveis e coerentes, e o Luma para transições suaves entre planos e ações, tudo dentro do mesmo fluxo de trabalho.

Visual prompts como ferramenta de direção de movimento

Um dos diferenciais práticos do Freepik é o recurso de Visual Prompt. Você desenha setas ou anotações sobre uma imagem base, indicando a trajetória de movimento desejada. O sistema interpreta essas indicações visuais, permitindo que braços se movam, portas se abram ou câmeras girem com precisão geométrica, sem necessidade de dominar a linguagem de prompts.

Variações e a geração de storyboards a partir de uma única referência

Freepik Variations é uma nova ferramenta de fluxo de trabalho criativo que permite gerar múltiplas variações visuais consistentes a partir de uma única imagem. Em vez de recriar imagens repetidamente ou começar do zero para cada nova versão, o Variations permite expandir uma única ideia visual em várias direções, mantendo alinhados identidade, composição e estilo. Na animação, ele funciona bem para storyboards e desenvolvimento de narrativas.

Áudio e pós-produção integrados ao fluxo de animação com IA

O Freepik oferece uma solução mais integrada, que inclui também a camada sonora da animação, algo que no Midjourney ainda costuma depender de ferramentas externas, como:

Lip Sync: sincroniza automaticamente o movimento labial dos personagens com arquivos de áudio ou vozes geradas por IA, essencial para narrativas com diálogos.

AI Voice e Music: gera vozes naturais em múltiplos idiomas e trilhas sonoras isentas de direitos autorais através do Freepik Tunes, reduzindo custos com licenciamento.

Upscale e Video Editor: amplia a resolução para 4K e permite edições básicas de corte e montagem sem sair da plataforma, diminuindo o número de softwares necessários no fluxo de produção.

Spaces: cria fluxos colaborativos nos quais modelos podem ser transformados em visualizações 360° realistas a partir de uma única imagem, economizando tempo em relação à modelagem 3D tradicional.

Leia também: Freepik Spaces: a aposta do Freepik para competir com Flora e Weavy e ampliar a criação colaborativa com IA

Estilos de animação com a IA

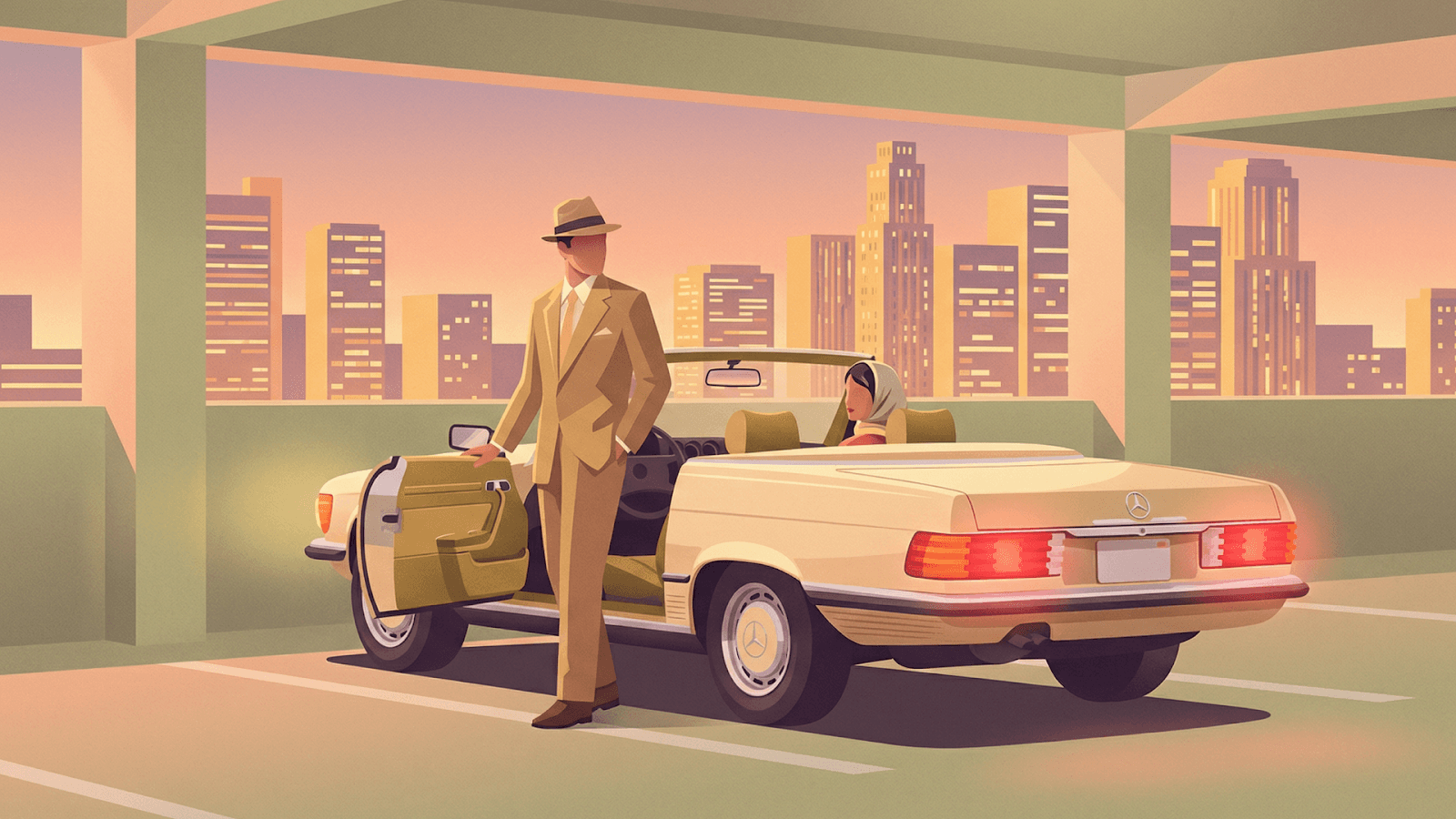

A animação com IA hoje não se limita a um único visual. Pelo contrário, ela atravessa estilos que vão do realismo cinematográfico ao traço artesanal, passando por abordagens híbridas e experimentais. Midjourney e Freepik ocupam posições complementares nesse cenário, oferecendo caminhos distintos para cada estética.

Realismo 3D e renderização cinematográfica com IA

Para produções que exigem alto grau de realismo visual ou animação 3D, o Midjourney V7 e modelos como o Mystic 2.5, disponíveis no Freepik, entregam resultados comparáveis a renderizações feitas em softwares como Octane ou Redshift.

Nesse campo, a IA permite explorar desde cenas com iluminação cinematográfica e controle de lentes até visualizações técnicas mais claras e organizadas. Perspectivas em vista de cima, por exemplo, funcionam bem em infográficos animados e apresentações explicativas. Já estilos que misturam referências orgânicas, tecnologia e padrões abstratos abrem espaço para curtas experimentais focados em formas, texturas e movimentos menos convencionais.

Animação 2D com IA

No 2D animado, o foco está na simplificação de formas, no uso consciente de cores sólidas e na valorização do traço.

No Midjourney, o destaque é o modelo Niji 7. Ele introduz um visual mais limpo e flat, com forte ênfase em desenho e contorno. O uso do termo anime screenshot nos prompts costuma gerar quadros que se aproximam de cenas prontas de animação, facilitando a construção de sequências consistentes.

No Freepik, há modos dedicados de “Anime” e “Cartoon” no gerador de vídeo, que se destacam na conversão de rascunhos e ilustrações simples em animações coloridas, funcionando bem em conteúdos educativos, séries curtas ou peças para redes sociais.

3D estilizado com IA

Aqui, o objetivo não é o realismo absoluto, mas volumes tridimensionais com proporções exageradas e traços caricatos.

No Midjourney, prompts como hero ou low-poly 3D animation funcionam bem. A partir da Versão 7, recursos como iluminação volumétrica e traçado de raios (ray tracing) ajudam a dar profundidade e presença a personagens estilizados.

Já no Freepik, motores como MiniMax e Kling lidam bem com a física de personagens 3D, garantindo movimentos fluidos mesmo em corpos com estética de boneco ou brinquedo, algo essencial para animações voltadas ao público infantil ou narrativas mais leves.

2D texturizado com IA

Esse estilo valoriza a sensação tátil da imagem e busca simular suportes físicos tradicionais.

No Midjourney, é possível aplicar termos como watercolor, charcoal sketch, felt texture ou paper texture para quebrar a rigidez digital. O parâmetro --style raw, disponível no V7, ajuda a preservar essas imperfeições orgânicas, evitando que a IA “limpe” demais a imagem.

No Freepik, o recurso Reimagine permite partir de um desenho 2D simples e aplicar sobre ele texturas de pintura ou ilustração clássica, criando variações visuais que mantêm o traço original, mas enriquecem a estética.

Stop Motion com IA

A animação quadro a quadro feita com materiais físicos também pode ser feita com IA.

No Midjourney, prompts como claymation style, plasticine animation ou handcrafted knitted permitem emular inclusive imperfeições típicas desse estilo, como marcas de dedos na argila ou irregularidades de superfície.

Em projetos que combinam diferentes ferramentas, é comum gerar as variações visuais no Midjourney e usar o Freepik para animar essas imagens, buscando o movimento característico do stop motion.

Animação híbrida: IA como copiloto criativo

Integração com fluxos tradicionais

A animação híbrida incorpora a IA em fluxos de trabalho já consolidados, tanto em 2D quanto em 3D. O objetivo é que o foco humano permaneça na direção de arte, na emoção e na intenção narrativa de cada cena.

Fluxos 3D assistidos por IA

No 3D, ferramentas integradas a softwares como Blender, Unity e Unreal Engine já permitem converter esboços 2D em modelos volumétricos por meio de soluções como Kaedim, acelerando significativamente a criação de assets.

A criação da estrutura de ossos e articulações (rigging) pode ser automatizada em segundos, uma tarefa que antes exigia dias de trabalho manual. Simulações de física baseadas em sistemas que analisam padrões de movimento humano e animal criam animações mais fluidas e naturais, algo que seria custoso ou demorado em fluxos convencionais de produção, mas que aqui ganha agilidade sem abrir mão da lógica criativa.

Híbrido 2D + 3D com IA

A combinação de elementos 2D sobre ambientes ou modelos 3D se popularizou.

Nesse fluxo, o conceito ou personagem pode ser criado em 2D no Midjourney, muitas vezes com o Niji 7, e depois integrado a cenários tridimensionais em softwares como Blender ou Unreal Engine. Ferramentas de IA também automatizam a criação de mapas de profundidade a partir de imagens 2D, permitindo que o desenho plano seja animado em um espaço tridimensional de forma mais coerente.

Essa combinação também permite alternar entre a precisão técnica do Freepik, com seus múltiplos motores de vídeo, e a sofisticação artística do Midjourney, especializado em traço, textura e estética.

O artista no centro do processo

Mesmo com o uso crescente de ferramentas inteligentes, o refinamento dos detalhes e a personalidade visual continuam sendo responsabilidade de quem cria. Artistas podem usar IA para transformar esboços em modelos 3D ou gerar texturas automaticamente, mas escolhas como iluminação, cores e narrativa visual permanecem decisões criativas, tomadas por pessoas, não por algoritmos.

Exemplos reais de animação com IA no mercado

Campanhas Publicitárias

A publicidade tem se tornado um verdadeiro laboratório para animação com IA. Um exemplo é o comercial “Masterpiece” da Coca-Cola, que combinou filmagens reais (live action), animação 3D tradicional e IA generativa via Stable Diffusion. A tecnologia foi usada para transições de estilos artísticos e para criar texturas animadas, resultando em uma fluidez impressionante entre o mundo real e estilos como Cubismo, Impressionismo e Pop Art.

Na Under Armour, a campanha “Forever is Made Now” com Anthony Joshua, dirigida por Wes Walker, utilizou IA para criar cenas inéditas sem precisar filmar o atleta novamente. A equipe aproveitou filmagens antigas do boxeador e aplicou IA para criar novos ambientes, texturas e até uma narração sintética. O resultado mistura 3D, colagem digital e vídeo granulado, com a estética “alucinatória” da IA usada propositalmente para reforçar intensidade psicológica.

Produções cinematográficas

No cinema, a IA tem permitido contar histórias ambiciosas, abrindo caminho para novas técnicas e possibilidades criativas. O filme Critterz, apoiado pela OpenAI, é um marco por integrar ferramentas de IA em todo o processo de animação. O curta já foi disponibilizado on-line em 2023, sendo remasterizado no ano passado, e a versão longa tem estreia prevista no Festival de Cannes em maio de 2026.

No Japão, o curta de anime The Dog & The Boy (Netflix Japan) combinou layouts iniciais feitos à mão com IA para gerar cenários e fundos detalhados, uma resposta à escassez de mão de obra na indústria de anime.

Comparativo de plataformas de animação com IA: Midjourney vs Freepik

Quando o Midjourney é a melhor escolha

O Midjourney continua líder em qualidade visual pura, com texturas, iluminação e sofisticação estética como seus pontos fortes. Recursos como Character Reference (--cref) e Style Reference (--sref) permitem manter estilo e personagem com precisão mesmo após centenas de gerações. O modelo de assinatura ilimitada em certos planos torna-o econômico para grandes volumes de pré-visualização.

Quando o Freepik se destaca

O Freepik se sobressai por oferecer um fluxo de trabalho unificado, incluindo remoção de fundo, upscale, retoque e dublagem diretamente na plataforma. O recurso de Visual Prompts torna a animação mais intuitiva para quem não domina a linguagem de prompts. A variedade de modelos permite escolher tudo dentro de uma única assinatura.

A principal limitação está no consumo de créditos: vídeos de alta qualidade ou treinamento de personagens personalizados podem esgotar recursos rapidamente, tornando o uso intenso mais caro.

Criatividade e decisão humana na animação com IA: o que não pode ser automatizado

Princípios fundamentais da animação

Mesmo com geração via IA, os 12 princípios de animação estabelecidos pela Disney continuam sendo a base para muitos artistas para alcançarem resultados visuais de qualidade. Elementos como encenação, apelo e timing ainda dependem da decisão humana para transmitir emoção, peso e intenção em cada quadro.

Os 12 Princípios da Animação

1️⃣ Comprimir e Esticar (Squash and Stretch): dá sensação de peso e flexibilidade.

2️⃣ Antecipação (Anticipation): prepara o espectador para a ação seguinte.

3️⃣ Encenação (Staging): direciona atenção e organiza a composição de cena.

4️⃣ Direta e Pose a Pose (Straight Ahead e Pose to Pose): métodos de desenhar quadro a quadro ou a partir de poses-chave.

5️⃣ Continuidade e Sobreposição (Follow Through e Overlapping Action): movimentos seguem leis físicas naturais, partes do corpo se movem em tempos diferentes.

6️⃣ Aceleração e Desaceleração (Slow In e Slow Out): movimentos ganham e perdem velocidade de forma realista.

7️⃣ Arcos (Arcs): movimentos seguem trajetórias curvas naturais.

8️⃣ Ação Secundária (Secondary Action): gestos adicionais dão mais vida à ação principal.

9️⃣ Temporização (Timing): define peso, ritmo e emoção de cada movimento.

1️⃣0️⃣ Exagero (Exaggeration): realça a essência da ação sem perder verossimilhança.

1️⃣1️⃣ Desenho Sólido (Solid Drawing): cria volume, peso e presença no espaço tridimensional.

1️⃣2️⃣ Apelo (Appeal): torna personagens interessantes e cativantes, com personalidade visual clara.

Animação, curadoria e o dia a dia com IA

A rapidez na geração de variações permite explorar caminhos criativos que antes seriam descartados por limitações de tempo ou até de orçamento. Ainda assim, a decisão final sobre o que entra ou não na cena e o que transmite a emoção certa continua sendo humana. A IA aprende padrões de movimento naturais a partir de grandes conjuntos de dados, mas quem decide se um movimento funciona para a narrativa ou transmite a intenção emocional desejada é o animador.

O design de personagens pode usar recursos como LoRA e Custom Characters, mas a concepção visual e a consistência permanecem sob controle humano. Na criação de cenários, preenchimento generativo e expansão de imagem permitem ambientes mais ricos e imersivos.

No fim, mesmo com toda a tecnologia disponível, é o animador quem dirige, escolhe e dá forma à história. A IA potencializa o processo, mas o controle criativo e a decisão final permanecem nas mãos humanas.

Recomendações práticas para profissionais de animação com IA

Adoção de fluxos híbridos

A maior eficácia está na combinação de técnicas. Use modelos como o Midjourney para criação de personagens e estilos, depois anime no Freepik e faça a pós-produção de forma manual. Essa abordagem aproveita o melhor do artista e as ferramentas à sua disposição, equilibrando qualidade estética com funcionalidade operacional.

Foco em consistência visual

O domínio de parâmetros como --cref no Midjourney ou o treinamento de Custom Characters no Freepik separa o amador do profissional. Consistência permite contar histórias longas e envolventes, não apenas clipes isolados. Invista tempo em aprender esses recursos, porque eles definem a qualidade final do projeto.

Exploração de multimodalidade

O uso integrado de vídeo, voz (AI Voice) e sincronia labial (Lip Sync) permite que criadores entreguem produtos acabados prontos para distribuição. Essa verticalização muda a lógica do audiovisual independente, ampliando possibilidades criativas.

Responsabilidade ética e legal

O profissional deve estar atento às regras de uso comercial e licenciamento de cada plataforma. É importante garantir segurança jurídica de suas obras conhecendo os termos de serviço, especialmente para projetos de clientes ou distribuição comercial.

Leia também: Workflow híbrido: combinando IA com ferramentas tradicionais

Conclusão: mais do que dominar IA, animar é sobre aprofundar repertório

A inteligência artificial não substitui o olhar do animador, ela amplia aquilo que ele já sabe fazer. Desde Branca de Neve e os Sete Anões, passando por Toy Story, Shrek e Spider-Verse, a história da animação sempre foi marcada por evolução técnica acompanhada de evolução sensível. A ferramenta muda, o olhar humano se aprofunda.

O receio diante de novas tecnologias também não é novidade. Como lembra Edwin Catmull, presidente da Pixar e da Walt Disney Animation, em Computer Animation: A Whole New World, quando o computador entrou nos estúdios, muitos artistas o enxergaram como ameaça, não como aquilo que ele viria a ser: um amplificador de possibilidades criativas.

A IA é apenas mais uma etapa desse mesmo movimento. Ferramentas como Midjourney, Freepik e outras conseguem gerar imagens e animações com estética sofisticada, mas não transformam ninguém em animador experiente da noite para o dia. E aqui vale lembrar três pontos-chave: estilo não nasce de prompt, narrativa não vem de modelo pronto e consistência não é automática. O verdadeiro diferencial continua sendo repertório, sensibilidade, direção e prática acumulada.

O caminho, então, não é resistir à IA, é reposicioná-la como aliada estratégica dentro de um processo criativo bem conduzido. São formações que unem domínio técnico e visão autoral que garantem produções relevantes, com o humano firme no centro das decisões.

É exatamente isso que move o AI VideoLab, o primeiro workshop do ano da Human dedicado à criação de animação com IA. Um laboratório prático, do conceito à cena final, onde você aprofunda direção de movimento, linguagem de animação, construção de narrativa e fluxos de trabalho, do 2D ao 3D, do realista ao stop motion, sempre com foco em consistência visual e aplicação real para o mercado.

Nos dias 28 de fevereiro e 1 de março, serão 12 horas de prática intensa, conduzidas por especialistas da Human, voltadas a quem entende que a IA pode apoiar a construção de narrativas, emoções e decisões criativas humanas.

👉 Faça sua inscrição no AI VideoLab: Animação com IA

Se a revolução já começou, a pergunta não é se você vai participar, mas quem vai dirigir o processo. A caneta continua na sua mão, e a gente mostra como transformar isso em animação de verdade.