26 de dez. de 2025

Nando

CEO | FOUNDER

Em 2025, o problema já não é falta de ferramenta. Modelos novos surgem o tempo todo, atualizações acontecem em ciclos cada vez mais curtos e nem tudo que é novidade se sustenta no uso real.

Na Human, usamos IA todos os dias, em contextos criativos, estratégicos e de produção. Isso cria um filtro natural: só permanecem no fluxo as que entregam consistência, controle e agilidade, sem atrapalhar a tomada de decisão criativa.

Este artigo não é sobre o que está “em alta”, é sobre o que funciona de verdade na nossa rotina criativa, da imagem ao vídeo, do conceito ao acabamento final. Aqui estão as Human Top Picks 2025.

Hubs criativos para quando a IA vira ecossistema

Hubs se tornaram peças-chave do fluxo porque resolvem um problema prático: trabalhar com múltiplos modelos sem fragmentar o processo. Eles permitem gerar estático, evoluir para vídeo, finalizar com upscale e, principalmente, pular de modelo para modelo com rapidez, testando abordagens sem fricção.

Freepik: agilidade com variedade de modelos

Funciona, na prática, como uma suíte criativa completa: você gera e edita imagens, cria vídeo e também trabalha com áudio dentro do mesmo ecossistema, com uma base massiva de assets para apoiar o processo. O próprio Freepik se posiciona como “all-in-one creative suite” e destaca centenas de recursos e geração por IA integrada.

O que faz diferença no dia a dia é ter variedade, o Freepik reúne múltiplos modelos, incluindo opções como Nano Banana, Flux, Seedream, Ideogram, GPT e outros, para você escolher entre velocidade, fidelidade, tipografia, realismo e consistência sem sair do lugar.

E no vídeo, o Freepik também organiza uma lista com especificações e custos por segundos, o que facilita decidir o certo para cada etapa, como entre a escolha de um protótipo rápido ou um clipe mais polido.

Em resumo, ele acaba sendo a escolha quando o time precisa de eficiência. Você explora visual, valida direção, troca modelo sem drama e segue para vídeo e ajustes com menos quebra de contexto.

👉 Leia também Freepik Spaces: a aposta do Freepik para ampliar a criação colaborativa com IA

LTX: produção de vídeo com foco em controle e fluxo profissional

Se destaca por algo raro: respeitar direção. Ele não tenta adivinhar tudo sozinho. Pelo contrário, oferece ferramentas para refinar intenção, ritmo e estrutura narrativa dentro do mesmo take.

A plataforma se posiciona como um motor completo, com geração de vídeo e áudio sincronizados, fidelidade 4K e múltiplos modos de desempenho. Em outras palavras, dá para equilibrar velocidade e qualidade sem abandonar o projeto no caminho.

No LTX, o ganho começa na escolha clara entre modos. LTX-2 Fast é o modo de ideação: quando você precisa testar ritmo, proposta de cena, intenção emocional e uma primeira estrutura de vídeo ou áudio sem travar o processo.

Já o LTX-2 Pro é o modo de entrega: quando você quer um resultado mais “apresentável”, com cara de peça final. Essa divisão de modos parece simples, mas na rotina ela muda tudo, porque evita o erro clássico de gastar energia e crédito antes da ideia estar fechada.

O que faz o LTX ser favorito na rotina criativa é que ele pensa do conceito ao corte final, não só um prompt e um clipe. E quando você cruza o LTX com hubs que também agregam modelos, você ganha algo precioso: direção contínua, com menos retrabalho.

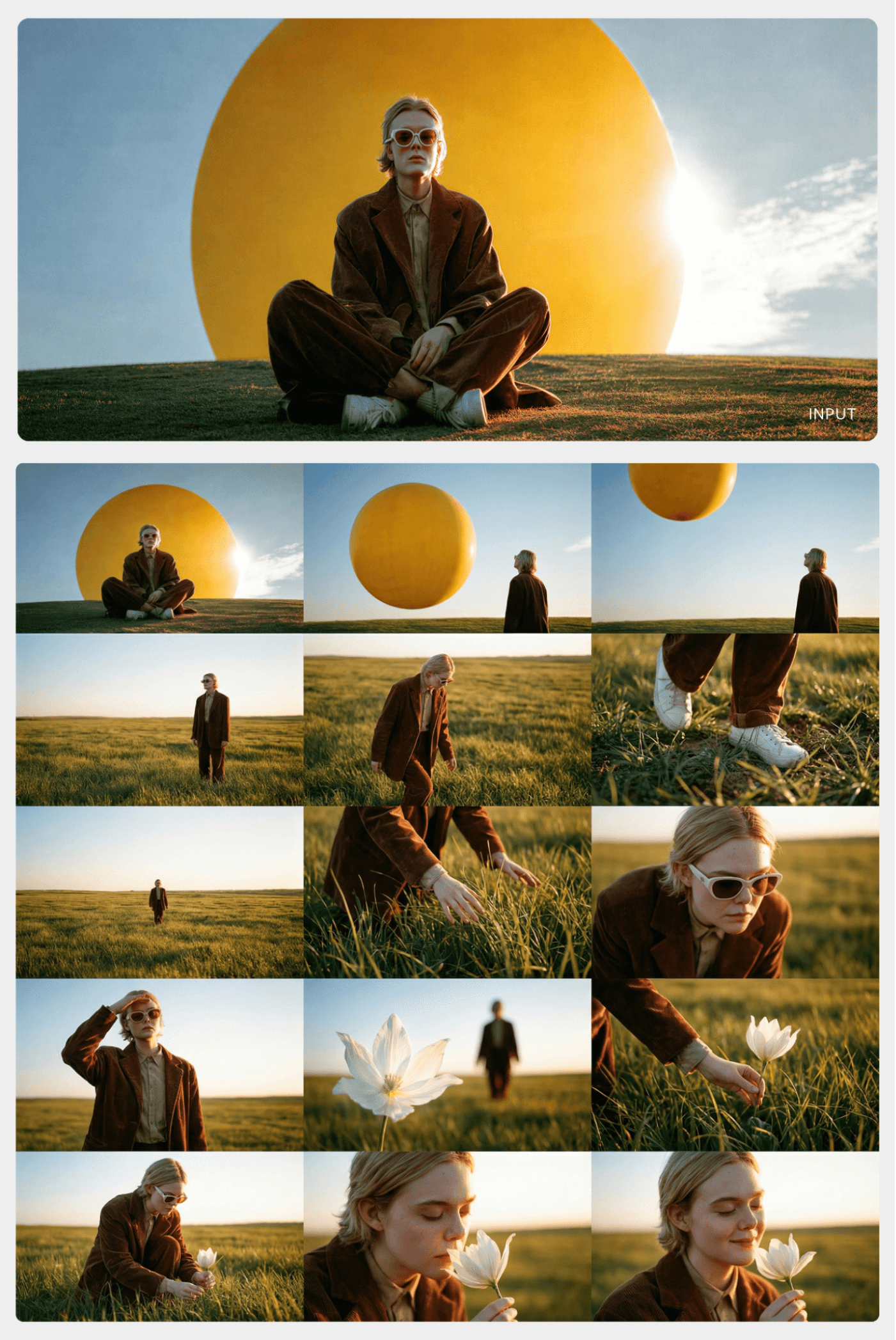

FLORA: canvas e workflows para quem precisa mesclar modelos

Entra como uma peça menos óbvia, mas estratégica. Ela ajuda a organizar processos, referências e fluxos criativos de forma visual e estruturada. Em um cenário onde ideias se multiplicam rápido demais, organização vira diferencial criativo. A proposta é clara: um plano, dezenas de modelos, para você não precisar ficar “caçando licenças” e trocando de ferramenta toda hora.

O ponto central é o canvas, com a lógica de blocos/nós para montar processos não-lineares: texto, imagem e vídeo viram partes conectáveis de um mesmo processo, em vez de etapas isoladas.

Essa filosofia aparece explicitamente no manifesto da FLORA, que bate numa tecla que a gente concorda muito: ferramentas de IA precisam dar controle criativo de verdade.

Na prática, para imagem, o destaque fica em modelos como Seedream 4.0, Flux Kontext Max ou Nano Banana para consistência e edição, e depois migrar para vídeo com Kling, Veo, Ray 2 (Luma) ou outros disponíveis no ecossistema.

Para o nosso uso, FLORA brilha quando o desafio é explorar caminhos, comparar capacidades, manter referência e organizar o pensamento visual sem transformar o projeto em uma colcha de retalhos de links e arquivos.

Onde os prompts realmente nascem

Antes de qualquer imagem bonita ou vídeo bem executado, existe uma etapa que define quase tudo o que vem depois: a construção do prompt. Na Human, ChatGPT e Gemini entram como ferramentas de raciocínio criativo. É aqui que a ideia ganha forma, estrutura e intenção antes de ser traduzida para o modelo visual escolhido.

Usar bem essas duas IAs muda completamente o resultado final, porque reduz tentativa aleatória e aumenta direção. Em vez de pedir algo genérico ao modelo de imagem ou vídeo, a gente chega com decisão tomada, vocabulário refinado e parâmetros claros.

ChatGPT + Gemini: estrutura, estratégia e clareza de intenção

São as principais ferramentas quando o desafio é pensar antes de gerar. Elas entram na organização de ideias, no refinamento conceitual e na tradução de referências abstratas em instruções claras. Na prática, usamos para:

estruturar prompts complexos, especialmente quando envolvem múltiplas cenas, personagens ou variações

transformar referências visuais em descrições objetivas

ajustar tom, linguagem e nível de detalhe conforme o modelo de destino

criar versões de prompt pensadas para teste rápido vs produção mais refinada

No fluxo, funcionam como um verdadeiro diretor assistente: ajudam a esclarecer o que queremos ver antes de gastar tempo e crédito gerando imagens ou vídeos. Isso é especialmente valioso quando o projeto exige consistência, narrativa ou lógica visual mais elaborada.

Imagem com consistência, linguagem e controle visual

O que separa uma ferramenta boa de uma ferramenta indispensável no fluxo é consistência, capacidade de interpretação e controle de linguagem visual. Na Human, os modelos de imagem entram com papéis bem definidos, e saber quando usar cada uma acelera decisões e eleva a qualidade final.

Nano Banana Pro: direção por edição, consistência por raciocínio

O Nano Banana Pro virou a primeira escolha em muita demanda porque ele combina duas coisas raras na mesma ferramenta: controle de edição e consistência em cenários que normalmente quebram modelos visuais.

Na prática, ele se destaca quando precisa ajustar luz e atmosfera, mudar ângulos, controlar foco, trocar proporção sem perder composição e, principalmente, resolver composições com múltiplas referências com menos surpresas desagradáveis.

O próprio Google posiciona o modelo como opção para resultados avançados, com renderização de texto aprimorada, controles precisos de edição (iluminação, ângulo de câmera e proporção) e resolução 2K, além do modo de “raciocínio” (Thinking).

O que muda no uso real é que ele não fica restrito ao “gerar do zero”. Ele entra como ferramenta de direção de arte assistida: você chega com uma base (ou várias) e pede para o modelo fazer o trabalho que normalmente exigiria idas e vindas entre ferramentas.

Esse é o tipo de modelo que acelera storyboard, variações de campanha e mockups com texto legível porque você consegue testar rapidamente intenção visual sem perder a mão da composição.

👉 Leia também Nano Banana Pro: o novo modelo do Google que redefine consistência, controle e criatividade

Midjourney: quando a imagem precisa ter “opinião” estética

O Midjourney é o modelo que a gente puxa quando o objetivo não é só “acertar”, mas propor. Ele continua sendo muito forte em visual mais conceitual, editorial e com presença, aquele tipo de imagem que já vem com atmosfera e direção embutidas.

No fluxo, ele costuma entrar como fase de exploração: criar linguagem, testar identidade, buscar uma solução visual menos literal e mais “com gosto”. E aí o uso prático fica bem claro: Midjourney é ótimo para abrir caminhos, e depois a gente decide se finaliza nele ou se leva a direção para um modelo mais orientado a controle/produção, dependendo do volume e da necessidade de consistência.

👉 Leia também Tutorial e dicas de Midjourney: guia completo do iniciante ao avançado

Seedream: previsibilidade e escala para produção visual

O Seedream entra quando o que a gente quer é um modelo confiável para rodar mais variações, explorar alternativas com velocidade e manter uma qualidade consistente sem ficar brigando com a interpretação.

A proposta do Seedream, inclusive, é justamente integrar geração e edição numa arquitetura única e manter consistência com referências, com saída de alta definição e foco em tarefas multimodais.

No uso real, quando a linguagem já está definida, ele ajuda a transformar direção em entrega, com menos “teimosia” do modelo. E isso importa muito quando o trabalho pede volume (campanhas, variações de social, desdobramentos) e quando a equipe precisa de previsibilidade para não perder tempo corrigindo ruído.

👉 Leia também Seedream vs Nano-Banana: análise das IAs de imagem mais poderosas de 2025

Recraft: vetor, mockup e edição como linguagem de layout

O Recraft merece um lugar separado porque ele não é só “mais um gerador de imagem”: ele opera com cabeça de design. Quando você precisa de materiais como vetores, ícones, layout com texto e mockups, o Recraft costuma ser mais direto do que insistir em modelos generalistas.

Ele é forte justamente por cobrir o que o dia a dia pede: geração e edição, vetorização, upscale, remoção de fundo, apagador, inpainting, além de recursos como outpainting, combinação de imagens e gerador de mockups. E, para quem trabalha com tipografia aplicada em peça, ele também se posiciona com foco em texto e consistência de marca dentro de uma plataforma de design.

O que faz diferença no fluxo é simples: no Recraft, a imagem vira ativo de design, não só visual bonito.

Vídeo é onde direção vira ritmo, corte e continuidade

No vídeo, o desafio é manter movimento convincente, continuidade entre takes, coerência de personagem, câmera com intenção e, cada vez mais, som. Por isso a Human usa modelos de vídeo com objetivos específicos: alguns são motores de “filmagem” (geração), outros de “pós” (edição e manipulação).

Veo: narrativa com cara de cinema e controle de cena no Flow

O Veo entra quando a missão é linguagem cinematográfica + consistência + controle. Ele brilha em takes que precisam parecer “filmados” (luz, textura, comportamento de materiais). É possível usar Flow como interface de construção/edição e trabalhar com prompts em JSON para deixar a intenção explícita (câmera, ritmo, atmosfera e som).

O diferencial no uso real é que o Veo não é só “texto → clipe”. Ele funciona melhor quando você pensa em sequência: um take com começo/fim definidos, transições mais fluidas (frames-to-video), e ajustes iterativos sem recomeçar do zero.

Seedance: multi-shot de verdade e consistência entre takes

O Seedance entra quando você precisa do que a maioria ainda sofre para entregar: multi-shot com coerência. Mantém personagem, atmosfera e estilo atravessando cortes, mudanças de plano e pequenas variações de tempo/espaço sem desandar tudo.

Na prática, ele é ótimo quando você já tem uma direção e quer transformar isso em micro-narrativa: abertura, desenvolvimento e fechamento em takes conectados, com movimento estável e leitura clara de prompt. É o tipo de motor que reduz a sensação de “colagem de clipes” e aproxima o resultado de um storyboard animado que já nasce com cara de filme.

Kling: realismo de movimento

O Kling costuma ser o escolhido quando você quer movimento humano convincente, física e realismo. E com as versões mais recentes trazendo áudio junto, ele vira uma opção forte para prototipar peça curta já com sensação de “vídeo pronto”: imagem + ambiência + voz/efeitos no mesmo output.

O diferencial no uso é velocidade de decisão. Em vez de gerar vídeo e depois correr atrás de som, você já consegue validar ritmo, intenção e timing da cena com áudio integrado, perfeito para teste A/B criativo, conteúdos rápidos e takes curtos.

Runway Aleph: pós generativa

Aleph é uma pós-produção generativa. Entra quando você já tem um vídeo (seu, filmado, ou gerado) e precisa transformar o take: trocar ângulo, mudar a estação do ano, relight, inserir/remover elementos, alterar ambiente, aplicar VFX, restyling, sem refazer tudo.

O diferencial prático é que ele encurta a distância entre “quase lá” e “fechou”. Sabe quando o take está bom, mas a luz não está, ou o cenário precisa mudar, ou falta um detalhe de cena? Aleph é o lugar onde você resolve isso com intenção de editor. É uma ferramenta muito forte para refinamento, correção e versões.

Luma: iteração rápida + qualidade alta

A Luma é ótima quando você quer entrar em estado de exploração: testar muitas ideias, achar o take com potencial e depois “masterizar” a melhor escolha. O posicionamento mais forte aqui é o combo de rápido para rascunhar + recursos de refinamento (keyframe/extend/upscale) e uma ambição clara de física e consistência.

No uso real, você explora, escolhe o que tem alma, e só depois investe no acabamento. É excelente para direção de arte em movimento, conceitos com câmera clara e cenas onde o “feel” importa tanto quanto a fidelidade.

Upscale: quando o detalhe vira acabamento

Entra quando a imagem ou o frame já estão resolvidos em linguagem, composição e narrativa, mas ainda precisam ganhar densidade, textura e presença para o uso real.

No fluxo criativo, essa etapa separa o rascunho bem resolvido do material pronto para ir ao mundo. É aqui que pele ganha microdetalhe, tecidos passam a ter leitura, superfícies ficam mais críveis e a nitidez deixa de parecer digital demais.

Magnific: acabamento final sem perder intenção

O Magnific entra no fim do processo, quando o objetivo é elevar uma imagem boa para nível final, sem alterar a direção que já foi definida antes. Na prática, a gente usa para extrair mais detalhe: textura de pele, grão, tecidos, materiais e profundidade.

O diferencial no uso real está no controle entre realismo e exagero. Quando bem ajustado, o Magnific não entrega aquela sensação de “upscale artificial”. Ele faz a imagem parecer que já nasceu em uma resolução maior, o que é essencial quando o material vem de modelos rápidos ou quando o frame vai passar por motion, composição ou color grading.

No fluxo da Human, o Magnific funciona como a última camada de cuidado. Você gera, decide, refina e só então dá upscale. É o passo que transforma experimento em peça pronta, sem comprometer a intenção visual construída ao longo do processo.

Conclusão: a IA acelera, mas quem decide é você

Em 2025, o que separa trabalhos medianos de projetos realmente fortes é como essas ferramentas entram no fluxo criativo.

Na Human, a IA funciona como extensão de direção, não como substituição de processo. A ideia nasce no raciocínio, ganha forma na imagem, vira ritmo no vídeo e só então recebe acabamento. Em muitos projetos, isso acontece de forma totalmente generativa. Em outros, começa com fotografia real, filmagem tradicional ou assets produzidos fora da IA, e tudo bem. O valor está na combinação inteligente.

Modelos como Nano Banana, Seedream, Veo, Seedance ou Luma aceleram decisões, ampliam possibilidades e reduzem fricção criativa. Ferramentas como Runway Aleph e Magnific entram para lapidar, corrigir e finalizar. E, quando faz sentido, softwares tradicionais de edição, color grading, motion ou VFX seguem sendo parte essencial do processo.

O ponto central é simples: não existe ferramenta única, existe direção clara. A IA vira poderosa quando trabalha a favor de uma linguagem, de um conceito e de uma intenção bem definida, não quando tenta resolver tudo sozinha.

Essas são as ferramentas que ficaram no nosso fluxo em 2025 porque passaram pelo único critério que importa: funcionam no uso real. Não pelo hype, mas porque ajudam a criar melhor, decidir mais rápido e entregar com mais qualidade.

E isso, no fim das contas, é o que define um bom trabalho criativo, com ou sem IA.