6 de fev. de 2026

Human Picks

Staff

Você gera um vídeo com IA, ele fica quase bom, mas precisa ajustar um detalhe. Ao abrir outra ferramenta, a continuidade visual se perde, tudo precisa ser regenerado e o personagem muda de cara entre as cenas. Você tenta manter a consistência manualmente, o processo leva horas e, às vezes, você desiste.

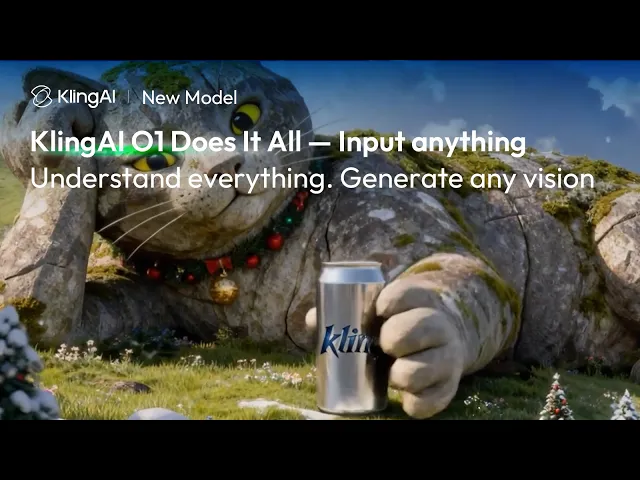

O Kling O1 promete atacar exatamente esse problema, unificando o que antes eram 18 funcionalidades separadas de geração e edição de vídeo em um único modelo multimodal. Você pode gerar a partir de texto, imagem ou vídeo, editar partes específicas do resultado, estender cenas, manter personagens consistentes e transformar o estilo visual sem sair da ferramenta.

Promessas à parte, o que realmente diferencia o Kling O1 do Runway, Luma e outros geradores de vídeo com IA? Como ele funciona na prática, onde faz sentido e quais limitações precisam ser consideradas antes de colocar ele no workflow? É a partir dessas questões que o Kling O1 começa a fazer sentido dentro de um processo criativo profissional.

Como o Kling O1 funciona na prática e o que ele resolve no vídeo com IA

A maioria dos geradores de vídeo com IA costuma funcionar assim: você escreve um prompt, a ferramenta gera um vídeo. Se não ficou bom, você ajusta o prompt e gera de novo. Se quiser editar um detalhe específico, precisa de outra ferramenta, ou se quiser manter um personagem igual em várias cenas, precisa de técnicas específicas ou ferramentas adicionais.

O Kling O1 opera de forma diferente. Ele foi construído como um sistema unificado que aceita texto, imagem e vídeo como entrada e permite edição contextual dentro do mesmo fluxo. Isso significa que você pode:

Gerar um vídeo a partir de texto e depois ajustar uma parte específica sem refazer tudo.

Subir uma imagem de referência e garantir que o personagem ou objeto se mantenha idêntico em diferentes cenas.

Pegar um vídeo existente e transformar o estilo visual completamente, de realista para animado, preservando o movimento original.

Estender a duração de uma cena mantendo a lógica de ação e continuidade.

Esse tipo de controle integrado elimina o ciclo de gerar, exportar, importar em outra ferramenta, editar, perder contexto e ter que recomeçar. Você trabalha num fluxo contínuo, ajustando iterativamente até chegar no resultado que precisa.

A diferença técnica está na arquitetura. O Kling O1 usa uma estrutura chamada Multimodal Visual Language (MVL), que processa texto e imagem juntos, como parte do mesmo raciocínio visual. Modelos tradicionais tratam texto e imagem separadamente e depois tentam combinar. No MVL, tudo é interpretado de forma integrada desde o começo, o que resulta em mais consistência e uma compreensão mais fiel da intenção criativa.

Como funciona o raciocínio do Kling O1 ao gerar vídeos com IA

Uma das inovações centrais do Kling O1 é o uso de raciocínio em cadeia, ou Chain-of-Thought (CoT), na geração de vídeo. Esse conceito vem de modelos de linguagem avançados, mas aqui é aplicado ao movimento e à física visual.

Funciona assim: antes de renderizar, o modelo processa internamente a lógica da ação descrita no prompt. Se você pede um personagem que tira os óculos e depois suspira, o modelo entende que são duas ações sequenciais, calcula a física do movimento da mão, a mudança de expressão facial e a transição temporal entre as etapas.

Na prática, isso se traduz em:

Movimentos corporais mais naturais, com mais respeito à anatomia e à gravidade.

Capacidade de entender instruções complexas que envolvem diferentes ações ao longo do tempo.

Simulação física mais consistente, onde objetos interagem de forma coerente, sem deformações ou comportamentos estranhos.

Para quem já está acostumado com a imprevisibilidade de outros geradores, o CoT traz mais controle. Você descreve a ação, e o modelo entende a sequência lógica do que precisa acontecer, em vez de apenas “chutar” o resultado a partir de palavras e imagens.

Quais são as principais funcionalidades do Kling O1 e quando usar cada uma

O Kling O1 consolida 18 habilidades distintas, mas, na prática, você vai usar principalmente seis funcionalidades centrais, dependendo do tipo de projeto.

1. Texto para vídeo (Text-to-Video)

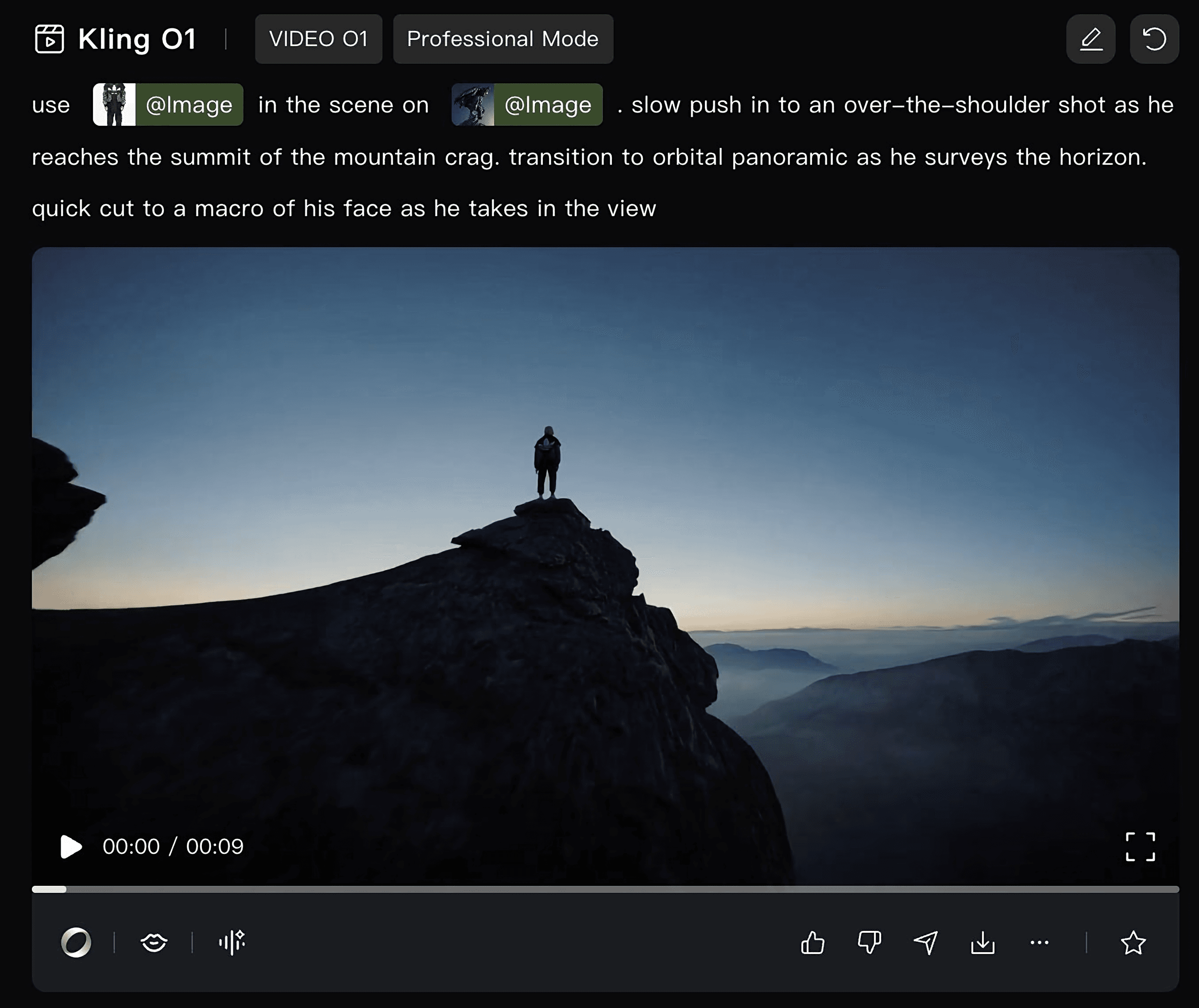

Você escreve uma descrição e o modelo gera a cena. Serve para prototipagem rápida, criação de conceitos visuais, testes de narrativa e até mudanças de ângulos. Funciona bem quando você tem uma ideia clara, mas ainda não precisa de controle total sobre cada elemento.

2. Referência para vídeo (Reference-to-Video)

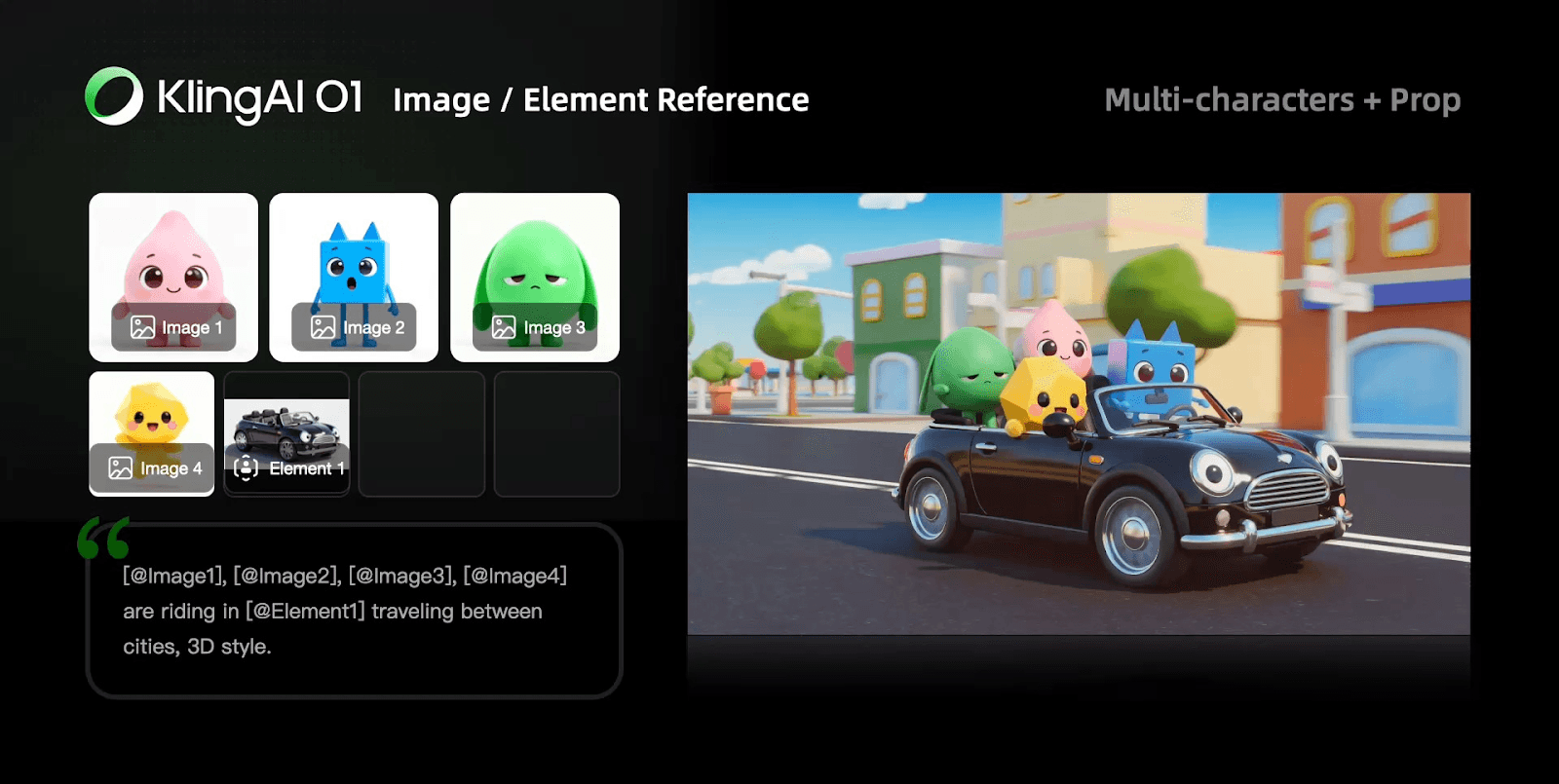

Você sobe uma imagem de um personagem, objeto ou cenário e o modelo garante que aquele elemento apareça idêntico no vídeo gerado. Essencial para manter consistência visual entre cenas, campanhas ou séries de conteúdo.

O sistema de Elementos (@Element) permite fazer upload de várias imagens do mesmo sujeito em ângulos diferentes. O modelo cria uma representação 3D mental e mantém a identidade visual estável, mesmo com mudanças de câmera ou ambiente.

3. Interpolação de keyframes

Você fornece um frame inicial e um frame final, e o modelo gera o movimento fluido entre eles. Isso dá controle preciso sobre o início e o fim da ação, deixando o modelo calcular a trajetória. Útil quando você já tem poses específicas definidas, como em storyboards ou animações que exigem posições exatas de personagens.

4. Edição e inpainting de vídeo

Você pega um vídeo já gerado e muda partes específicas com comandos de texto. Pode adicionar, remover ou transformar elementos dentro da cena sem regenerar tudo.

Por exemplo: trocar o fundo de uma cena, mudar a cor de um objeto, adicionar um elemento que estava faltando. A edição acontece de forma contextual, respeitando a iluminação, perspectiva e movimento da cena original.

5. Extensão de cena (Shot Extension)

Você tem um vídeo de 5 segundos e precisa de 10. O modelo estende a cena mantendo a lógica de movimento e ação. Isso evita cortes bruscos e permite criar sequências narrativas mais longas.

Funciona melhor em cenas com ação contínua do que em cortes estáticos, já que o modelo precisa entender a direção do movimento para prolongar de forma coerente.

6. Transformação de estilo (Style Transfer)

Você pega um vídeo existente e transforma completamente o estilo visual, de realista para animado, de live-action para ilustração, de fotográfico para algo mais artístico. O movimento e a ação se mantêm, mas a estética muda. Útil para explorar variações estilísticas de um mesmo conceito ou adaptar conteúdo para diferentes linguagens visuais sem precisar refilmar ou reanimar.

Kling O1, Runway e Luma: qual gerador de vídeo com IA usar em cada caso

Runway Gen-4.5, Luma Dream Machine e Kling O1 são algumas das ferramentas mais usadas para criar vídeo com IA hoje. Cada uma tem propostas diferentes e performa melhor em cenários específicos.

Runway Gen-4.5

Forte em velocidade de geração e controle de câmera. Tem uma interface consolidada, uso bem estabelecido no mercado e comunidade ativa. Funciona bem para quem precisa iterar rápido, testar variações e gerar volumes grandes de conteúdo.

Limitação: menos controle sobre edição contextual dentro do vídeo gerado. Se você precisa ajustar um detalhe, normalmente regenera.

Luma Dream Machine

Forte em cenas com intenção cinematográfica, especialmente no uso de iluminação e textura. Funciona bem para conteúdos que pedem alto impacto visual.

Limitação: menos funcionalidades de edição e menor consistência de personagem.

Kling O1

Unifica a geração e edição, tem melhor controle de consistência de personagem com o sistema de Elementos, capacidade de transformar estilo visual mantendo o movimento e edição contextual de partes específicas do vídeo.

Limitação: curva de aprendizado maior, interface menos intuitiva que Runway, velocidade de geração um pouco mais lenta que Luma em alguns cenários.

Quando usar cada um:

Use Runway quando precisar de velocidade, volume e iteração rápida. Use Luma quando o projeto pede cenas pensadas com uma linguagem mais próxima do cinema e maior impacto visual. Já o Kling O1 faz mais sentido quando você precisa de consistência visual entre cenas, controle fino de edição ou transformações de estilo a partir de conteúdo já gerado.

Em projetos que exigem séries de vídeos com personagens recorrentes, campanhas com identidade visual coesa ou workflows híbridos que misturam geração e edição, o Kling O1 oferece uma vantagem estrutural clara.

Leia também: Comparativo de IA de vídeo: Veo 3, Kling, Seedance, Freepik, Higgsfield e Sora

Quais são as principais limitações do Kling O1 no vídeo com IA

O Kling O1 resolve problemas importantes, mas ainda tem algumas limitações que podem afetar o uso profissional.

Tempo de processamento

Gerações complexas com múltiplas referências podem levar vários minutos. Se você precisa iterar rápido ou testar muitas variações, esse tempo se acumula. Para workflows de alta velocidade, Runway ainda é mais ágil.

Curva de aprendizado

A interface não é tão intuitiva quanto a do Runway ou do Luma. O sistema de Elementos, a interpolação de keyframes e as opções de edição contextual exigem um tempo de experimentação até fazerem sentido. Não é algo totalmente imediato, do tipo “abrir e sair criando”.

Qualidade visual inconsistente

Embora o raciocínio em cadeia melhore a física e o movimento, a qualidade estética final ainda pode variar. Algumas gerações se aproximam mais de uma linguagem visual de cinema, enquanto outras acabam com textura artificial ou iluminação estranha. Ainda é necessário regenerar e testar.

Custo

O Kling O1 consome mais créditos por geração do que modelos anteriores da própria Kling. Em volumes altos de produção, isso pode pesar no orçamento. Vale calcular o gasto por vídeo antes de escalar.

Ecossistema em desenvolvimento

O Kling O1 ainda está construindo sua base e se consolidando. Tutoriais da comunidade e casos de uso práticos já começam a surgir, mas o nível de maturidade ainda não é o mesmo de ferramentas como Runway, Luma ou até mesmo de outros modelos dentro do ecossistema Kling.

Quando faz sentido usar o Kling O1 no vídeo com IA

O Kling O1 não é uma ferramenta universal para todo tipo de vídeo com IA. Ele se destaca em cenários específicos onde a unificação de geração e edição resolve gargalos reais do processo criativo.

Faz sentido usar quando:

Você está criando uma série de vídeos com os mesmos personagens ou elementos visuais recorrentes.

O projeto exige múltiplas iterações de edição sobre o mesmo material gerado.

Você precisa transformar o estilo visual de conteúdo já existente sem refazer a captura ou animação.

O fluxo envolve ajustes finos e controle mais detalhado, não apenas geração em massa.

Você trabalha com storyboards ou keyframes definidos e quer automatizar a interpolação entre eles.

Não faz tanto sentido quando:

Você precisa de velocidade máxima e está criando vídeos pontuais sem necessidade de consistência entre eles.

O projeto envolve alto volume, prazos apertados e prioriza quantidade em vez de controle fino.

O principal critério é alcançar uma estética próxima da linguagem de cinema, e você pode regenerar várias vezes até chegar ao resultado desejado.

Você está começando com IA para vídeo e quer a curva de aprendizado mais suave possível.

Para quem atende clientes corporativos com demandas de identidade visual consistente, agências criando campanhas em série, ou creators construindo universos visuais com personagens recorrentes, o Kling O1 pode ser uma boa opção.

O que muda na prática ao criar vídeos com IA com o Kling O1

Com um modelo multimodal unificado, o fluxo se torna iterativo dentro do mesmo ambiente. Você gera, ajusta, refina, transforma e mantém contexto visual sem quebrar a continuidade.

Isso muda a forma como você planeja o projeto. Em vez de pensar em entregas isoladas, você pode pensar em versões progressivas. Gerar um conceito inicial, testar variações de estilo, ajustar detalhes específicos, estender cenas conforme necessário, tudo no mesmo lugar.

Para quem trabalha com clientes, isso pode reduzir o ciclo de feedback. Você pode mostrar uma versão, receber ajustes e aplicar mudanças pontuais sem precisar explicar que vai ter que regenerar tudo e o personagem pode mudar de aparência.

O ganho não é só de tempo, é de controle criativo. Você dirige o resultado em vez de ficar preso à possível aleatoriedade do modelo. Com isso, o vídeo se torna mais maleável, editável, ajustável, não só uma coleção dividida do que funcionou ou não funcionou.

Ainda existem limites e nem toda edição vai funcionar perfeitamente. Nem toda extensão de cena vai manter a qualidade e nem toda transformação de estilo vai preservar todos os detalhes, mas a direção é clara: ferramentas de IA para vídeo estão evoluindo para ambientes de criação integrados.

O que vem depois do Kling O1

O Kling O1 não é um ponto final, mas um marco de um processo em andamento. A unificação de geração e edição em um único modelo multimodal resolve problemas, mas também revela novas oportunidades.

O próximo passo provável é a integração com ferramentas de pós-produção tradicionais. Hoje, você ainda precisa exportar o vídeo gerado e levar para o Premiere, After Effects ou DaVinci para finalizar. A tendência é que esses ambientes comecem a incorporar funcionalidades de IA multimodal nativamente, ou que as ferramentas de IA evoluam para cobrir mais etapas do fluxo.

Outro caminho é o ajuste fino em tempo real. Modelos como o Kling O1 ainda operam de forma isolada, você envia um comando, o modelo processa e retorna. Não há iteração visual em tempo real, não há ajuste durante a geração. Quando isso se tornar viável, a forma de dirigir vídeo com IA vai mudar de novo.

E, claro, qualidade. A física está melhorando, a consistência está evoluindo, mas ainda existe distância entre o que a IA gera e o que uma câmera captura ou um animador cria manualmente. Conforme os modelos amadurecem, essa distância diminui, mas não vai desaparecer por completo.

Nesse cenário, o papel humano se torna ainda mais central, mais valor existe em direção criativa, repertório, intenção estética e tomada de decisão. O ganho real está em ter mais tempo e clareza para explorar ideias, testar caminhos e conduzir o processo criativo com consciência.

Para quem trabalha com vídeo, o movimento é claro: aprender a dirigir IA como ferramenta criativa, não como gerador automático. Entender o que o modelo faz bem, o que ele faz mal, onde economiza tempo, onde ainda exige trabalho manual e, principalmente, saber quando usar e quando não usar.

É exatamente dessa lógica que parte o AI VideoLab, o laboratório prático da Human dedicado à criação de vídeos com IA. Em dois dias de estúdio aberto, entre 28 de fevereiro e 1 de março, você acompanha processos reais de criação, explorando diferentes linguagens de vídeo, fluxos de trabalho e decisões criativas que vão muito além do prompt. Aqui, a IA não é o fim, mas o meio para transformar intenção em resultado de vídeo consistente.

O Kling O1 é uma peça importante nesse cenário. Não porque resolve tudo, mas porque mostra que é possível combinar fluxos que antes eram fragmentados. E quando você unifica, ganha controle, que é o que transforma uma ferramenta interessante em algo que realmente serve ao processo profissional.

Quer seguir aprofundando no ecossistema da Kling? Confira nosso artigo sobre o áudio nativo em vídeo com IA no Kling 2.6 e entenda como som e imagem também começam a se integrar no mesmo processo criativo.