4 de fev. de 2026

Human Picks

Staff

Se você já gerou vídeos com IA, conhece bem a frustração: você roda o prompt, espera o resultado e percebe que um detalhe específico ficou errado. Em muitos casos, a solução acaba sendo gerar tudo de novo e torcer para que, dessa vez, funcione. É a famosa “roleta de prompts”, um fluxo ainda comum em várias ferramentas e que limita o controle criativo.

Com o lançamento do Firefly Video e a integração de recursos como edição via prompt, controle de câmera, upscaling com Topaz Astra, AI Object Mask e Media Intelligence, a Adobe começa a estruturar um fluxo de vídeo com IA que vai da captura em câmera física à finalização, tudo dentro do mesmo ecossistema.

O ecossistema de IA da Adobe ficou mais robusto, mas o que, de fato, muda com esses novos recursos? Como eles funcionam na prática, em que situações o Firefly faz sentido dentro de um workflow profissional e quais dores reais da produção de vídeo ele ajuda a resolver?

O que é o Firefly Video Editor e para que ele serve

Anunciado em outubro de 2025 na Adobe MAX e já disponível em beta público, o Firefly Video Editor é uma ferramenta de edição de vídeo acessada via navegador. Ele não foi pensado para substituir o Premiere Pro, e essa diferença é central para entender sua proposta.

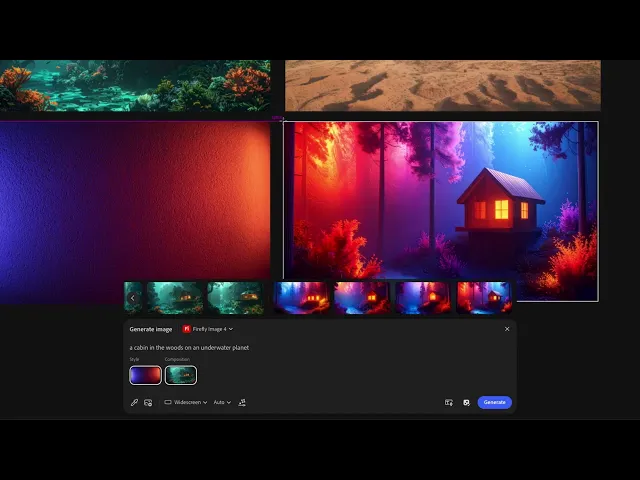

O Firefly funciona como um espaço de montagem rápida para conteúdo gerado por IA. Nele, é possível criar clipes com os modelos disponíveis no ecossistema Adobe, como Firefly Video Model, Runway, Luma e Veo, combinar esses materiais com filmagens próprias, adicionar trilha sonora, ajustar tudo na timeline e exportar o resultado.

O editor oferece duas formas de trabalho: a timeline tradicional, que permite controle sobre cortes, camadas e timing, e a edição baseada em texto, pensada para entrevistas ou conteúdos falados, em que cortes e reorganizações podem ser feitos diretamente na transcrição.

Edição localizada de vídeo com IA no Firefly

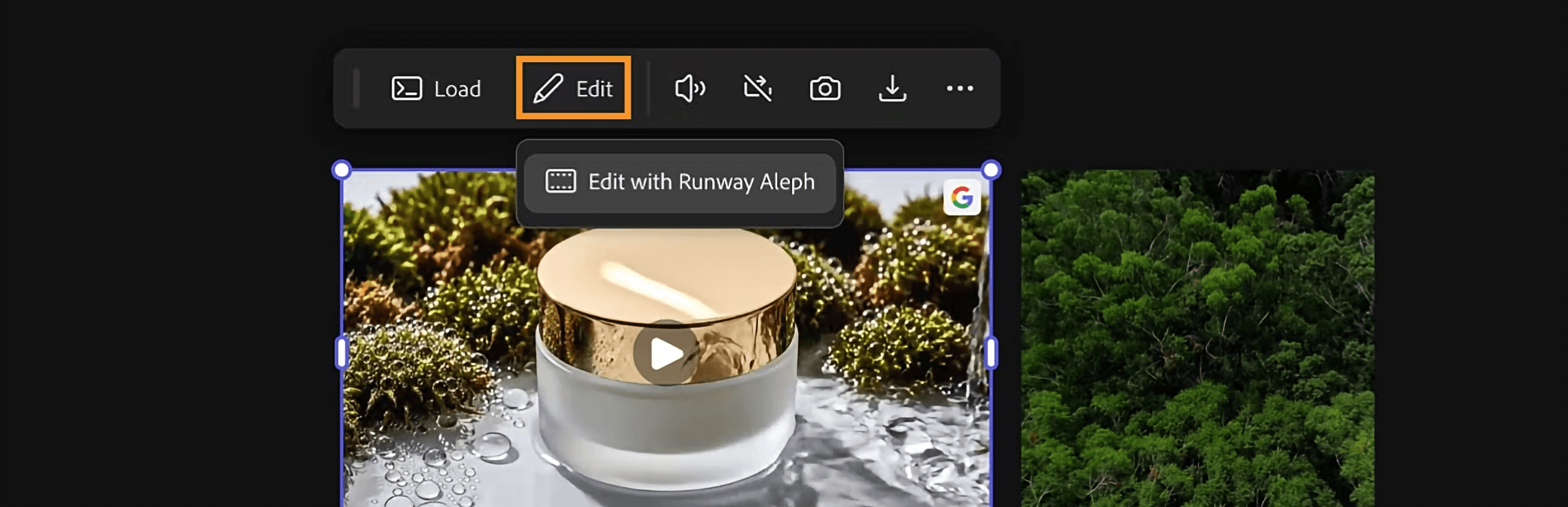

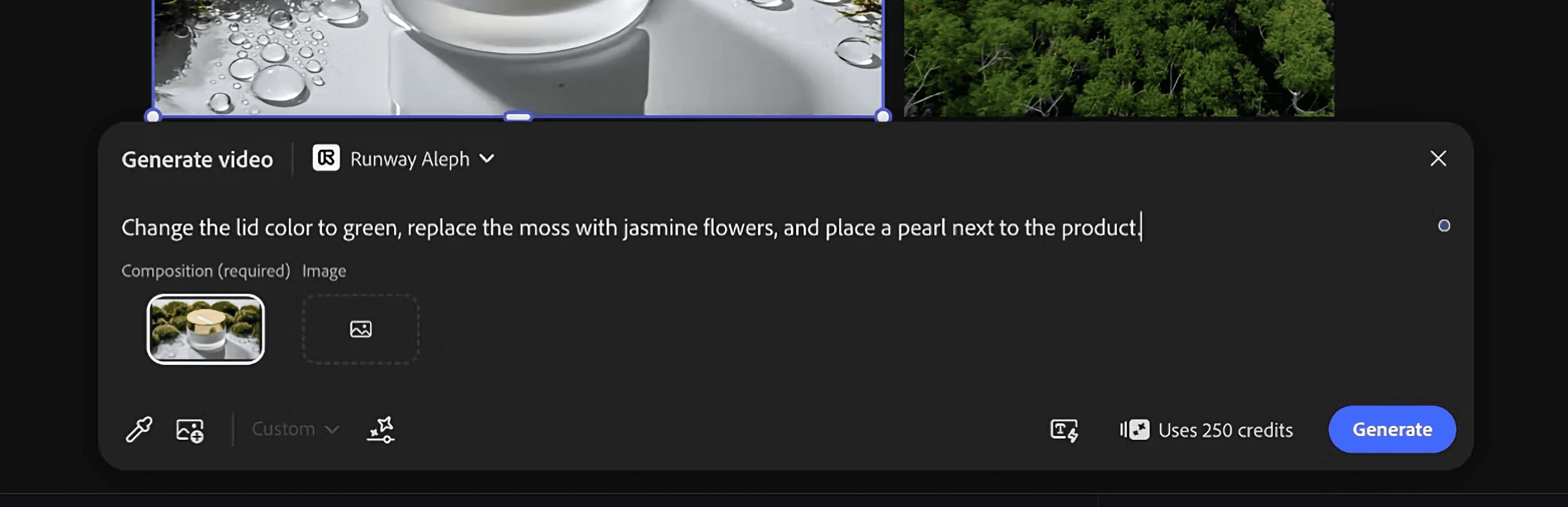

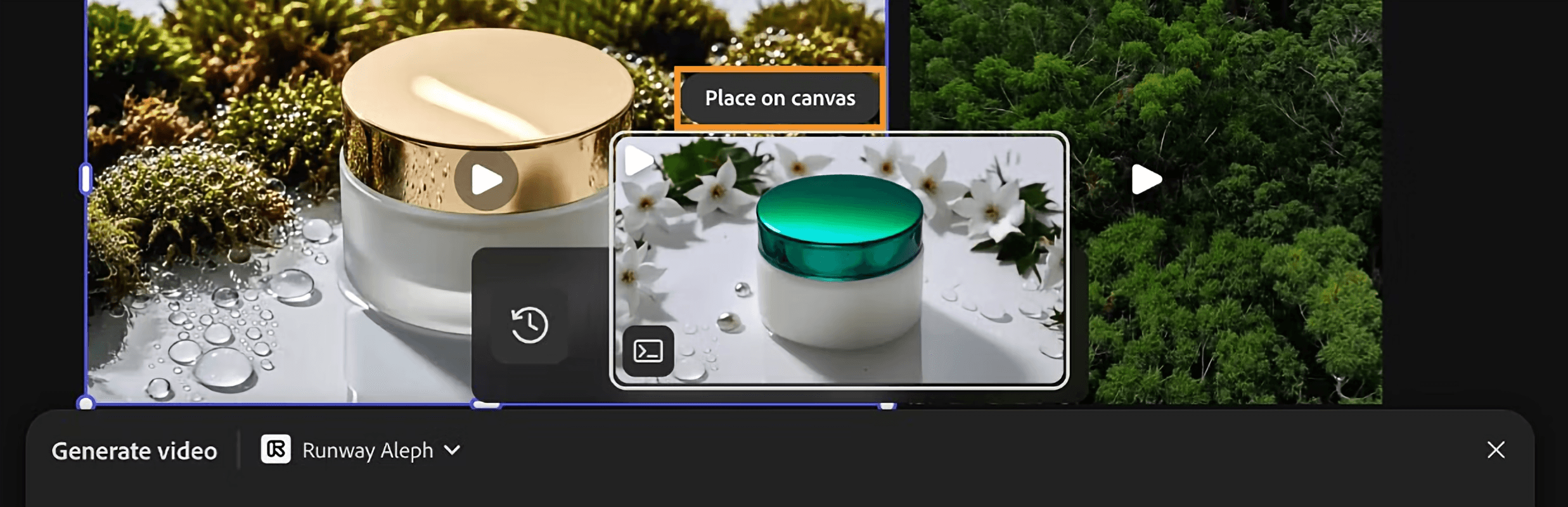

Até pouco tempo, ajustes simples em vídeos gerados por IA costumavam exigir um novo render completo. O Prompt to Edit surge como uma alternativa a esse fluxo. Em vez de recomeçar, ele permite fazer ajustes pontuais em trechos específicos do vídeo já gerado, usando linguagem natural para orientar a edição.

O recurso utiliza o modelo Aleph, da Runway, integrado ao Firefly. Na prática, o processo é simples: você faz o upload do clipe que deseja ajustar, descreve o que precisa mudar e a IA aplica a edição diretamente sobre o vídeo existente.

Comandos como “trocar o céu para nublado e diminuir o contraste”, “dar um leve zoom no personagem principal” ou “substituir o objeto da mesa por uma caneca de café” ilustram bem o tipo de ajuste possível nesse fluxo.

Vale lembrar que o Prompt to Edit não faz milagres. Ele funciona melhor para ajustes de elementos específicos, cores, iluminação e pequenas substituições. Para mudanças estruturais de cena ou movimento complexo, ainda pode ser necessário regenerar ou combinar com outras técnicas de edição.

Como isolar pessoas e objetos em vídeo com IA no Premiere Pro

Entre as novidades anunciadas na Adobe MAX 2025, o AI Object Mask no Premiere Pro chama atenção por atacar um gargalo comum da edição de vídeo. O recurso identifica e isola automaticamente pessoas e objetos nos quadros.

Segundo a Adobe, o AI Object Mask pode ser até 20 vezes mais rápido do que métodos tradicionais de mascaramento. Na prática, o recurso agiliza tarefas como correção de cor seletiva, desfoque de fundo, aplicação de efeitos visuais e qualquer ajuste que exija isolar um elemento específico da cena. O editor seleciona o objeto, a IA cria a máscara e acompanha automaticamente o movimento ao longo do tempo.

Além do AI Object Mask, o Premiere Pro também recebeu ferramentas complementares de mascaramento, como Rectangle Mask, Ellipse Mask e um Pen Masking redesenhado, todas com acompanhamento automático de movimento e precisão em nível de quadro.

Para editores que lidam com muitas camadas, produtos em vídeo ou cenas visualmente complexas, esses recursos reduzem o tempo gasto em tarefas técnicas repetitivas e liberam mais espaço para decisões criativas ao longo do processo.

Como usar IA para encontrar cenas no Premiere Pro

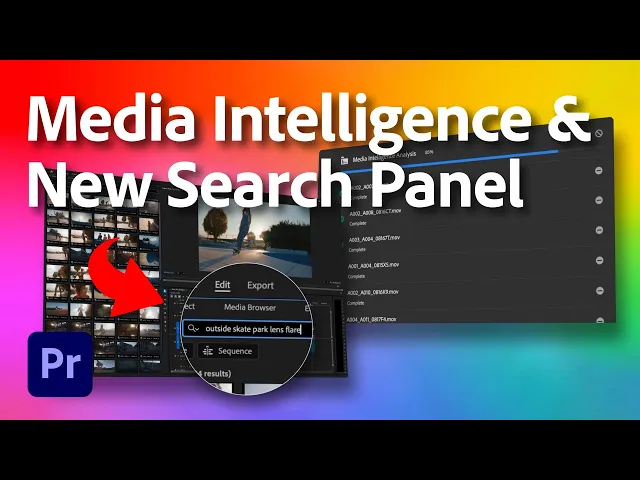

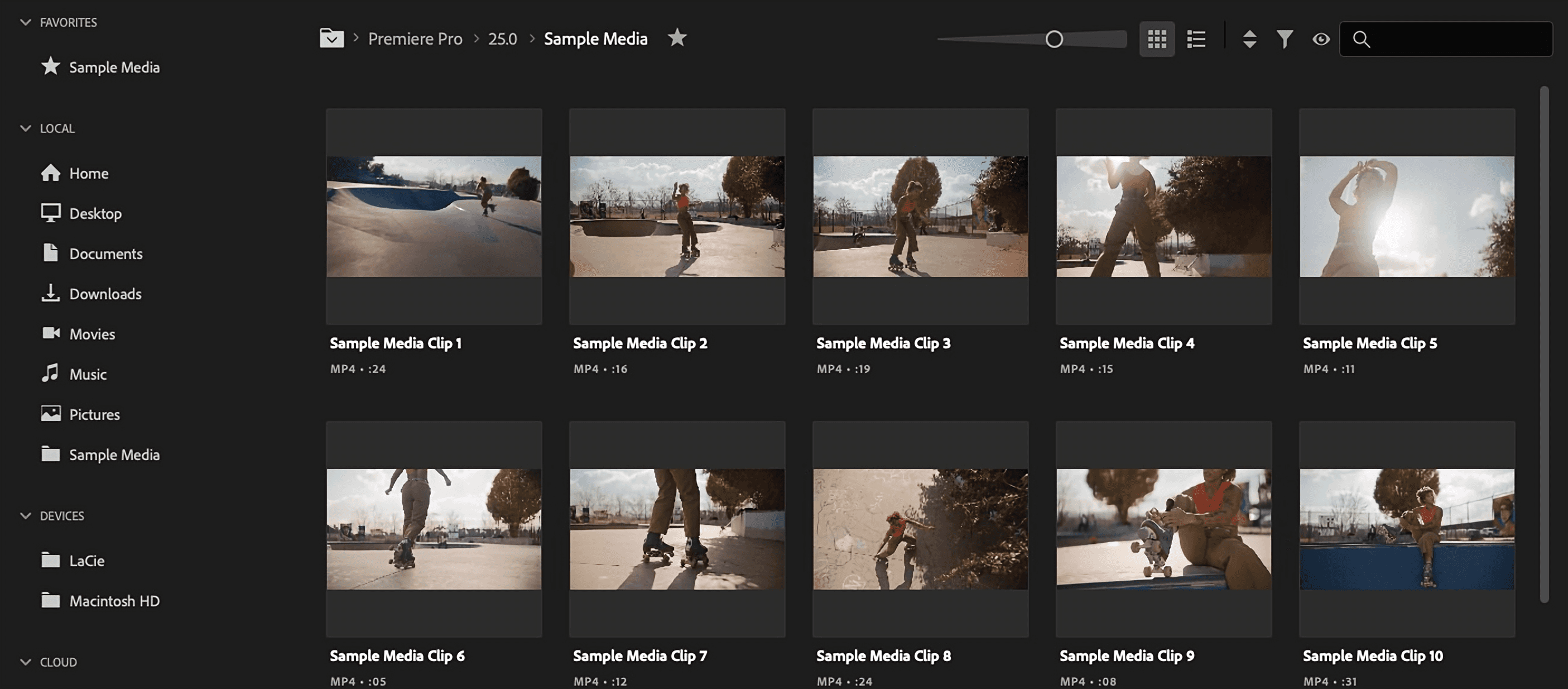

Outro recurso que chegou ao Premiere Pro em 2025 é o Media Intelligence, um sistema de busca que permite encontrar cenas usando descrições em linguagem natural. Em vez de depender apenas do nome dos arquivos ou de uma organização manual complexa, o editor pode simplesmente escrever o que está procurando.

Quer localizar cenas de skate a céu aberto? Ou clipes gravados em abril de 2025 com uma câmera específica, como a ARRI ALEXA? O Media Intelligence cruza essas informações automaticamente. Também é possível buscar falas específicas, já que o sistema transcreve o áudio e permite pesquisar pelo conteúdo dito em cena.

O funcionamento é simples do ponto de vista do usuário. Ao importar os arquivos, o Premiere analisa automaticamente as imagens, o áudio e as informações básicas do material, como data de gravação e tipo de câmera. Essa análise fica salva junto ao projeto, sem alterar o arquivo original. Quando uma busca é feita, o Premiere compara o texto digitado com essa leitura do conteúdo e retorna os trechos mais próximos do que foi descrito.

A busca combina diferentes tipos de informação em um só lugar. É possível procurar elementos visuais, dados de gravação e trechos falados ao mesmo tempo. O painel de busca reúne tudo e permite refinar os resultados conforme a necessidade.

Como resume o editor Ernie Gilbert, do filme Opus, da A24, essas ferramentas ajudam a remover parte do trabalho repetitivo do processo e liberam mais tempo para decisões criativas que realmente impactam a audiência.

Vale destacar que toda essa análise acontece localmente no computador do usuário. O material não é enviado para a nuvem, nem utilizado pela Adobe para treinar modelos de IA. O recurso também pode ser desativado nas preferências do Premiere, caso o editor prefira não utilizá-lo.

Controle de câmera com IA: uso de vídeo de referência no Firefly

Outro avanço importante é o controle de movimento de câmera no Firefly Video Model. Agora, além de descrever o movimento no prompt, você pode fazer upload de uma imagem ou vídeo de referência para mostrar exatamente o tipo de movimento que você quer.

Por exemplo: você quer um dolly in suave em um personagem. Em vez de tentar descrever a velocidade e a trajetória em palavras, você grava (ou encontra) um vídeo com esse movimento e usa como referência. O Firefly Video Model aplica esse mesmo movimento na sua cena gerada.

Combinado ao Prompt to Edit, esse controle de câmera permite preservar um bom take gerado logo na primeira tentativa, ajustando apenas os pontos necessários. O foco deixa de ser a tentativa aleatória e passa a ser a direção criativa aplicada ao processo.

Camera to Cloud no Premiere Pro: do set de filmagem direto para a edição

O fluxo da Adobe com IA e colaboração começa antes mesmo da pós-produção. Com a integração Camera to Cloud, ou C2C, via Frame.io, câmeras compatíveis conseguem enviar o material gravado diretamente para a nuvem enquanto a filmagem ainda acontece.

Na prática, isso permite que um diretor de fotografia esteja filmando em um local enquanto um editor, em outra cidade ou país, já recebe os takes, testa cortes e envia feedback quase em tempo real. Não é preciso esperar o fim do dia de gravação, copiar arquivos para HDs externos ou transportar cartões de memória entre equipes.

Modelos de fabricantes como RED, Fujifilm, Nikon, Canon, Panasonic e Leica já oferecem suporte a esse fluxo. Em alguns casos, câmeras conseguem enviar arquivos de alta resolução ou versões proxy automaticamente, tudo de forma integrada e sem a necessidade de equipamentos extras.

Dentro do Frame.io, o material pode ser organizado, comentado e aprovado, e depois encaminhado diretamente para o Premiere Pro, Lightroom ou After Effects. Segundo a Adobe, mais de 5.000 produções já utilizaram esse sistema, incluindo séries como WeCrashed, eventos esportivos do Golden State Warriors e produções da Red Bull Media.

Upscaling com IA no Firefly: como aumentar a resolução de vídeos com Topaz Astra

A Adobe integrou o Topaz Astra ao Firefly Boards para ampliar a resolução de vídeos gerados com IA. Na prática, isso permite pegar um clipe criado em resolução mais baixa e escalar para 1080p ou 4K sem sair do ambiente do Firefly.

O Firefly Boards funciona como um espaço de experimentação visual. É ali que você testa variações, compara resultados, ajusta ideias e escolhe a melhor versão antes de levar o material para a edição. O upscaling acontece exatamente nesse momento do processo, quando o vídeo já está definido, mas ainda precisa ganhar resolução.

Por enquanto, esse recurso está disponível apenas no Boards e ainda não chegou ao Firefly Video Editor. O fluxo sugerido é testar e selecionar o clipe no Boards, aplicar o aumento de resolução e depois levar o resultado para o editor ou para o Premiere Pro.

Integração de modelos no Firefly: Runway, Luma, Veo, FLUX.2 e outros

A Adobe vem posicionando o Firefly não apenas como um gerador próprio, mas como um ponto de encontro entre diferentes modelos de IA. Além das soluções desenvolvidas internamente, a plataforma já integra opções de terceiros como Runway, Luma AI, Veo do Google, ElevenLabs e o FLUX.2.

O FLUX.2, por exemplo, é voltado à geração de imagens realistas, não de vídeo. Ele aparece em áreas como Firefly Text to Image, Prompt to Edit, Firefly Boards e ferramentas generativas do Photoshop. A vantagem é poder alternar estilos e abordagens sem sair do ecossistema Adobe.

Para vídeo, o Firefly reúne modelos com propostas diferentes. O modelo próprio da Adobe prioriza uso comercial seguro. O Runway Aleph é usado para ajustes localizados e edição contextual. O Luma AI se destaca pela estética cinematográfica. O Veo, do Google, é forte em realismo e comportamento de movimento.

Essa estratégia parte de um princípio simples: nenhum modelo resolve tudo. Dependendo do tipo de cena, do estilo visual ou da necessidade técnica, um modelo pode entregar resultados melhores que outro. Ter essas opções centralizadas reduz atrito, facilita testes e acelera decisões.

O que muda para quem cria vídeo com IA hoje

Mais do que novos recursos, o Firefly aponta para uma mudança de postura no uso da IA. O criador passa a dirigir o processo, corrigir detalhes, ajustar movimentos e decidir o que fica e o que muda.

A possibilidade de editar sem refazer tudo, de usar referências visuais para controlar a câmera e de encontrar cenas rapidamente em grandes volumes de material muda a relação com a ferramenta.

Ainda existem limites claros: o Firefly Video Editor não cobre todas as necessidades de edição. Alguns recursos estão restritos a áreas específicas da plataforma. Nem tudo é automático ou perfeito, mas a direção já é mais consistente.

Se você já usa Adobe, vale testar. Se você está procurando uma forma de organizar seu workflow de vídeo com IA, da captura em câmera até a entrega final, o Firefly pode ser o hub que centraliza tudo.

O ponto central deixa de ser a geração em si e passa a ser o processo. Entender o que vem antes da imagem ou do vídeo, intenção, referência, narrativa, ritmo, é o que sustenta qualquer projeto audiovisual. Sem visão humana e critério criativo, nenhuma tecnologia se sustenta sozinha. No fim, o foco não é mais a ferramenta, mas pensar criação com IA de forma consciente, integrada e profissional.

É exatamente isso que você acompanha no AI VideoLab, o laboratório prático da Human. Um espaço para ver cenas sendo pensadas, dirigidas e construídas ao vivo, do conceito ao resultado final. Nos dias 28 de fevereiro e 1 de março, com estúdio aberto, você acompanha a criação de animações com IA do início ao fim, em tempo real, com erros, acertos, ajustes e decisões criativas acontecendo na prática.

Você vai ver movimento, linguagem audiovisual, consistência estética e construção de cenas em estilos 2D, 3D, realista, stop motion e fluxos híbridos.

Se fizer sentido para você, aqui está o caminho.

Para se aprofundar ainda mais em como a Adobe integra IA nos fluxos de criação, leia também nosso artigo Photoshop no ChatGPT: como a integração da Adobe reorganiza edição de imagens e design com IA.